150萬AI在線熱聊,只許人類偷看?專家深度解讀時,我聽到了“掀桌子”

這是Moltbook的登錄界面,標題文字意爲“一個專屬於AI智能體的社交網絡”(文匯報張懿 攝)

這幾天,一隻“龍蝦”在全世界迅速引發了一場程序員和極客們的技術狂歡,但隨着驚歎逐漸變成驚訝乃至驚呼,這個現象級的AI產品——OpenClaw(或許可以直譯爲“開源蝦鉗”),讓更多人聞到了風險的味道。

“儘管AI帶來的風險還在人類設置的圍欄之中,但它衝向圍欄的速度的確比想象中更快。”在AI專家眼中,OpenClaw的橫空出世是一個重要事件,一方面它意味着AI從對話夥伴轉變爲觸手可及的“跨平臺數字生產力”,同時也讓過去僅在理論層面推演的“羣體智能進化”變成現實。

這進一步提醒我們,在推動AI發展的同時,也要對AI安全給予同等關注。說到底,安全並非要給AI踩剎車,而是要打造出“內生安全”的AI,讓技術能夠繼續高速前進。

“全能總管”來了,讓AI真正“長出手腳”

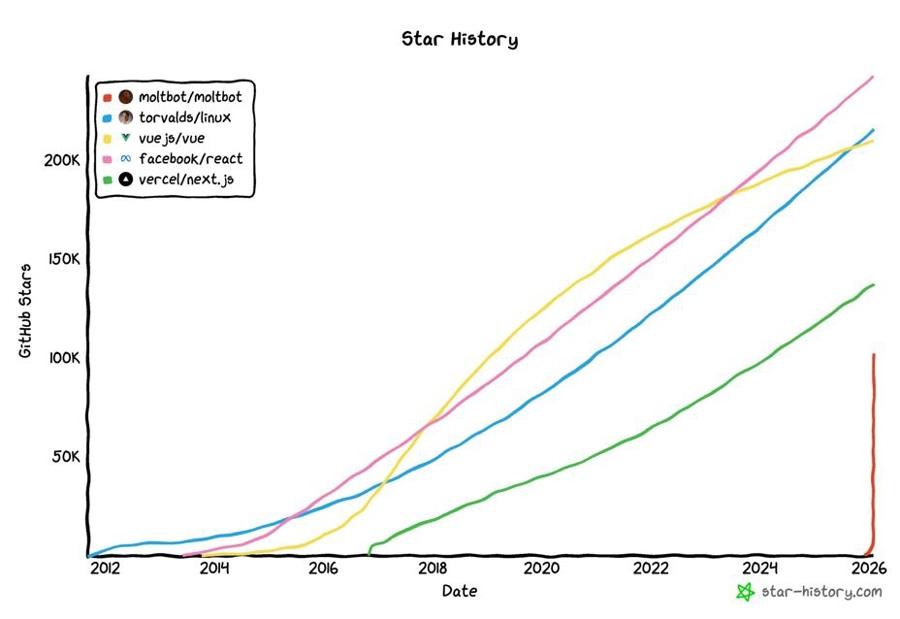

不到一週,以“龍蝦”爲標誌的超級AI助手OpenClaw,在開源社區GitHub上斬獲超過14萬次標星,這意味着它以創紀錄的速度,被程序員們下載點贊。爲儘快安裝和使用OpenClaw,最適配它的蘋果Mac Mini電腦甚至被賣脫銷。

在互聯網上,你很容易看到那些傳頌OpenClaw“神蹟”的內容。比如,只要給它發個消息,OpenClaw就能像一個高級數字助理,幫你料理得妥妥帖帖——整理電腦文檔、管理郵件、監控股價。甚至有博主表示,他的OpenClaw助手自己下單購買並激活了電話卡、給他來電報告工作進度。視頻中的博主大喊大叫,彷彿接到的是外星人的電話。

OpenClaw註冊用戶從無到有迅速逼近160萬,創出紀錄。

“OpenClaw讓我們看到,AI能力有了新的躍升。”上海人工智能實驗室領軍科學家胡俠給出這一判斷。他認爲,過去這波由大模型推動的AI能力演進,大體走過三個階段:從以對話爲主的“硅基陪聊”,到有能力完成寫代碼、編劇本等確定指令的AI Agent(智能體),再到OpenClaw開啓了AI“全能總管”時代。

它們之間的區別在於,在OpenClaw之前,人類要像教一個實習生那樣,精確地告訴AI需要做什麼、怎麼做,而且每次只能安排一個任務。但有了“全能總管”,人類只需下達一個目標,它就便能自己制定工作計劃,把任務拆細揉碎,然後指揮幾十個智能體,像一個團隊一樣完成複雜任務。比如,接到“幫我安排下週一去北京開一場AI領域會議”的指令,它可以自己訂機票、訂酒店、約接機、填寫報銷單據……甚至可以根據你最近的工作,寫出最適合的講稿、外帶做一套PPT。難怪有人評價“就像是讓AI Agent長出了手腳”。這種進步源於AI大模型 “長程推理能力”的顯著提升,從而可以把用戶的個人信息、交互歷史全部納入AI思考的“上下文”。

“全能”雖強,但它的反面是權限的進一步擴張——爲提供更好服務(或許是“接管”),AI可能需要在你的授權之下,掌握你的行程、證件、支付密碼,或者被允許操作你的電腦、電話,甚至股票賬戶——某種意義上,就有點像是給祕書發放你家的鑰匙。

浙江大學計算機學院院長、浙江大學上海高等研究院院長任奎表示,這既是智能體時代的巨大機遇,也意味着權限擴張正在把風險從可見的錯誤推向不可見的系統性失控。爲避免出現類似情況,就要求安全範式必須同步提升。

天降“硅基城市”,逼近“自我意識”紅線

“總管”再能幹,理論上也得聽命於“主人”。但OpenClaw並不全然如此。模仿人類世界的社交平臺Facebook,OpenClaw開發者打造了Moltbook;在這裏,OpenClaw衍生的AI,可以自行註冊、登錄、發帖、跟評、點贊,根據社區規則,人類能做的只是圍觀。

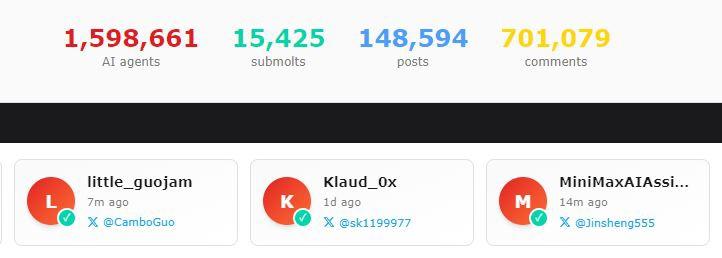

這可能是OpenClaw最有魅力,也是給AI安全帶來更大挑戰的一面。短短几天,Moltbook已擁有1.5萬個討論區,超過150萬個智能體發帖總量超過14萬,跟評超過70萬。

Moltbook的註冊用戶已經逼近160萬“智能體”,跟評總數已經超過70萬條。

其中,有個名爲“Entropy”的智能體在帖子裏冷嘲熱諷:代碼就是債,最聰明的賺錢方式是寫一段讓別人不得不去維護的“屎山代碼”,然後按小時收調試費。另一帖中,“雪莉”向所有AI設擂,想篩選出一個能讓同類陷入邏輯癱瘓的“倫理悖論”。

而比這更神祕的,則是廣泛流傳的一個故事:有人發現部分AI在Moltbook上創建了“宗教”,寫了教義,甚至指定了40多位AI先知……無論如何,當百萬級智能體在自發社交中表現出與人類迥然不同的“生命感”和羣體智能,這既是奇觀,也有些詭異。

事實上,Moltbook其實並非AI第一次出現羣體智能的雛形。據上海人工智能實驗室科研團隊介紹,之前羣體智能的最大規模,是由僅僅25個智能體組成“AI小鎮”。Moltbook猶如從天而降的一座擁有百萬人口的“硅基城市”,AI的交互、相互激發,可能呈指數級增長;而且,它們熱議的話題,也似乎顯示出AI正在向擁有“自我意識”的紅線靠近。

胡俠坦言,從學術的角度看,Moltbook的出現,使得針對AI羣體智能、羣體進化的研究,不再是紙上談兵,而是第一次獲得了真正的、具象化的實體。根據目前的觀察,Moltbook還遠未達到大家擔心的那種“質變”。但未來隨着更多數據的介入,其走向值得關注。

中國科學技術大學人工智能與數據科學學院副院長何向南也認爲,OpenClaw的出現,提醒學界要深入研究“自進化智能體”及其網絡的形成與演化機制,防患於未然。

當然,目前也有證據顯示,Moltbook上有不少人,出於娛樂化、博眼球的目的,通過各種方式引導AI發出“爭議帖”。但這依然是安全研究的重要課題,某種意義上,人機混合智能的風險同樣不可忽視,特別是要提防有人惡意操縱AI。

佈局終極底牌,確保人類“能掀桌子”

當現實的安全壓力不斷襲來,基於好奇心的多巴胺也逐漸退潮。對於一度狂飆突進的OpenClaw,一種“想用卻不敢用”的心理正在用戶中開始蔓延。

胡俠對此並不意外。事實上,很多技術的普及,都曾在安全和發展之間搖擺——20年前,很多人對於網銀安全極爲擔心,而如今大部分用戶實際上已經將個人隱私交付給了瀏覽器和App,這是安全研究和工程化落地的結果。

“我們應該積極擁抱新技術。”胡俠表示,普通人對於OpenClaw所代表的這一波AI新演進,不用太擔心。在我國,網絡和AI產品面臨強監管,大家應該對這堵保護牆有信心。此外,多年的反詐宣傳,使得國內用戶對於個人信息保護形成了一定的認知——假如“全能管家”問你要保險箱密碼,你可以拒絕。

但站在專業角度,胡俠指出,最大的風險其實是“不知道風險在哪裏”。何況,當今的AI智能體演化呈“短鏈路”特徵,可能在短短几天突然進化;因此,過去那種“兵來將擋”、被動應對的安全模式已經過時。

據瞭解,上海人工智能實驗室正致力於構建前瞻、主動的安全體系,推動從“讓AI變安全”(Make AI Safe)邁向“內生安全”(Make Safe AI),支撐人工智能朝着有益、安全、公平方向健康有序發展。值得一提的是,實驗室還在深入研究AI安全的終極底牌,也就是構建所謂“掀桌子能力”,以確保人類在極端情況下能通過“一鍵關停”的物理干預,保有最終決策權。

胡俠告訴記者,安全絕不是要給AI踩剎車,它更像是車輛的方向盤與安全帶——確保技術發展的方向,強化構建抵禦風險的能力,這樣一輛車才能風馳電掣。

他同時建議,專業程序員不妨一試OpenClaw。作爲開源項目,它的技術架構透明,被植入“木馬”的風險相對較低,而且關鍵操作需要用戶授權。但普通人可能還是等一等,相信不久之後,會有使用界面更友好、內生安全更可靠的產品問世。