攢臺量子計算機,到底是上風冷好還是上水冷好?

對電腦有一定了解的讀者朋友一定知道,攢機的時候,除了 CPU、主板、內存等等的硬件,還有個系統也非常重要,那就是“散熱”,無論是風冷還是水冷,必須把各種元件尤其是 CPU 和顯卡產生的熱量帶走,才能讓設備穩定發揮出應有的性能。

筆記本電腦發熱。圖片來源: AI 生成

而“量子計算機”有沒有這樣的系統呢?答案當然是有,而且要求遠比普通計算機嚴苛,不僅如此,量子計算機還需要配備一些普通計算機上並不存在的系統,才能正常運行,接下來我們就一起看看吧。

製冷系統

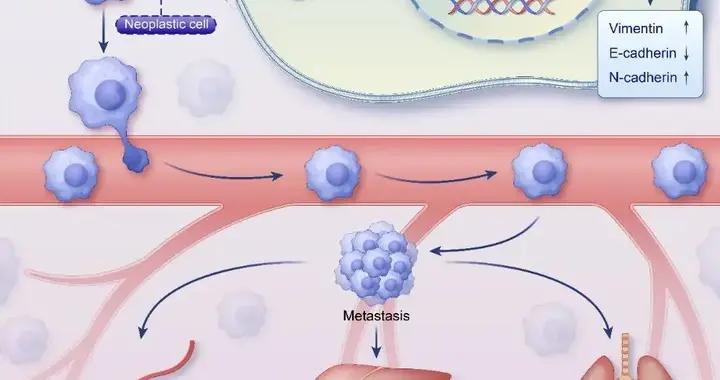

以超導量子計算機爲例,由於超導量子比特的能級差非常微小,量子態極易受到外界環境的擾動而退相干。目前已知的主要干擾因素包括:

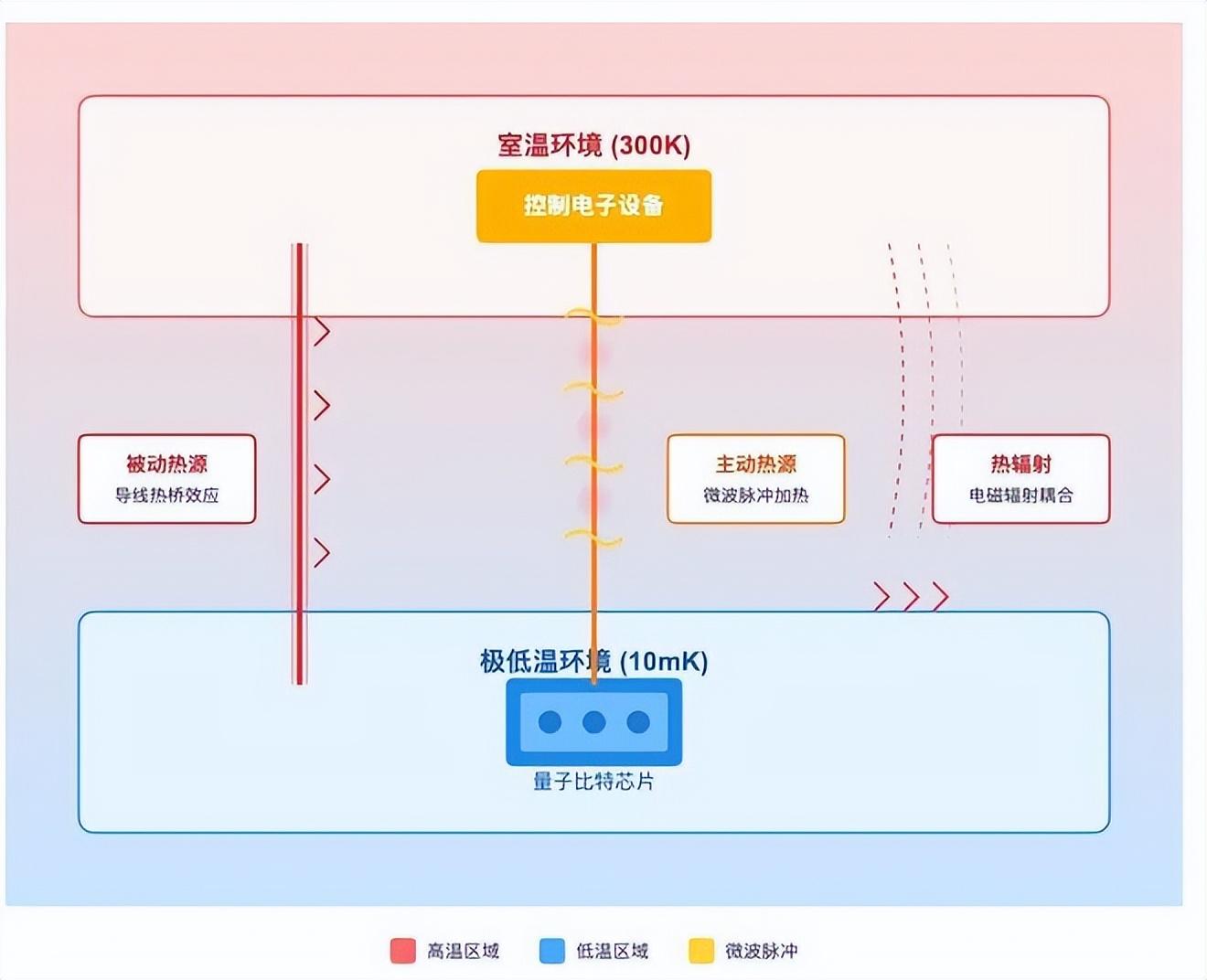

·被動熱源:量子比特雖然在接近絕對零度的環境裏,但它必須通過導線和室溫的電子設備相連。導線就像一根“熱橋”,會把高溫環境的熱量帶到低溫區。

·主動熱源:操控量子比特需要發射微波脈衝,脈衝會沿着導線傳輸。在傳輸和衰減的過程中,總會有能量轉化爲熱量,積累起來就會加熱環境。

·熱輻射:即使導線和材料都隔離處理過,量子芯片和外界之間仍然存在電磁輻射耦合,高溫的環境會向低溫的芯片“輻射熱量”。

圖1量子比特的三大熱干擾源

爲了儘量隔絕這些影響,現行做法是:

·選用熱導率、電導率合適的材料製作導線;

·在信號路徑中加入濾波器和衰減器,削弱非必要頻段以及控制信號傳輸所逸散的能量;

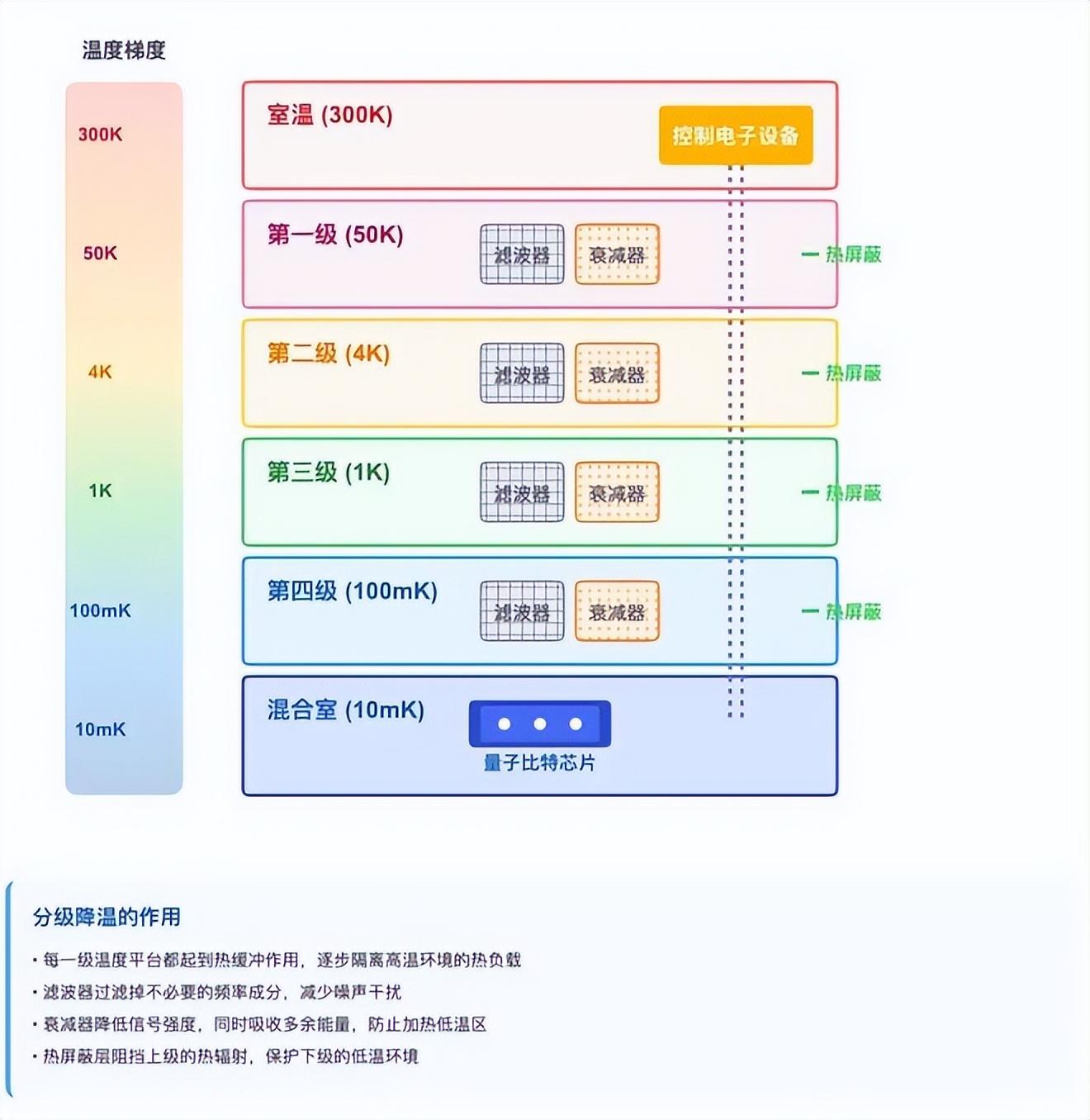

·使用稀釋製冷機進行分級降溫(不是直接從室溫降到 10 mK,而是依次經過室溫→50 K→4 K→1 K→100 mK→10 mK),逐步屏蔽熱源。

圖2稀釋製冷機分級降溫系統

稀釋製冷機分級降溫系統, 分級降溫的作用有很多。首先,每一級溫度平臺都起到熱緩衝作用,逐步隔離高溫環境的熱負載。而濾波器可以過濾掉不必要的頻率成分,減少噪聲干擾。衰減器除了能降低信號強度,還可以吸收多餘能量,防止加熱低溫區。而熱屏蔽層能阻擋上級的熱輻射,保護下級的低溫環境。

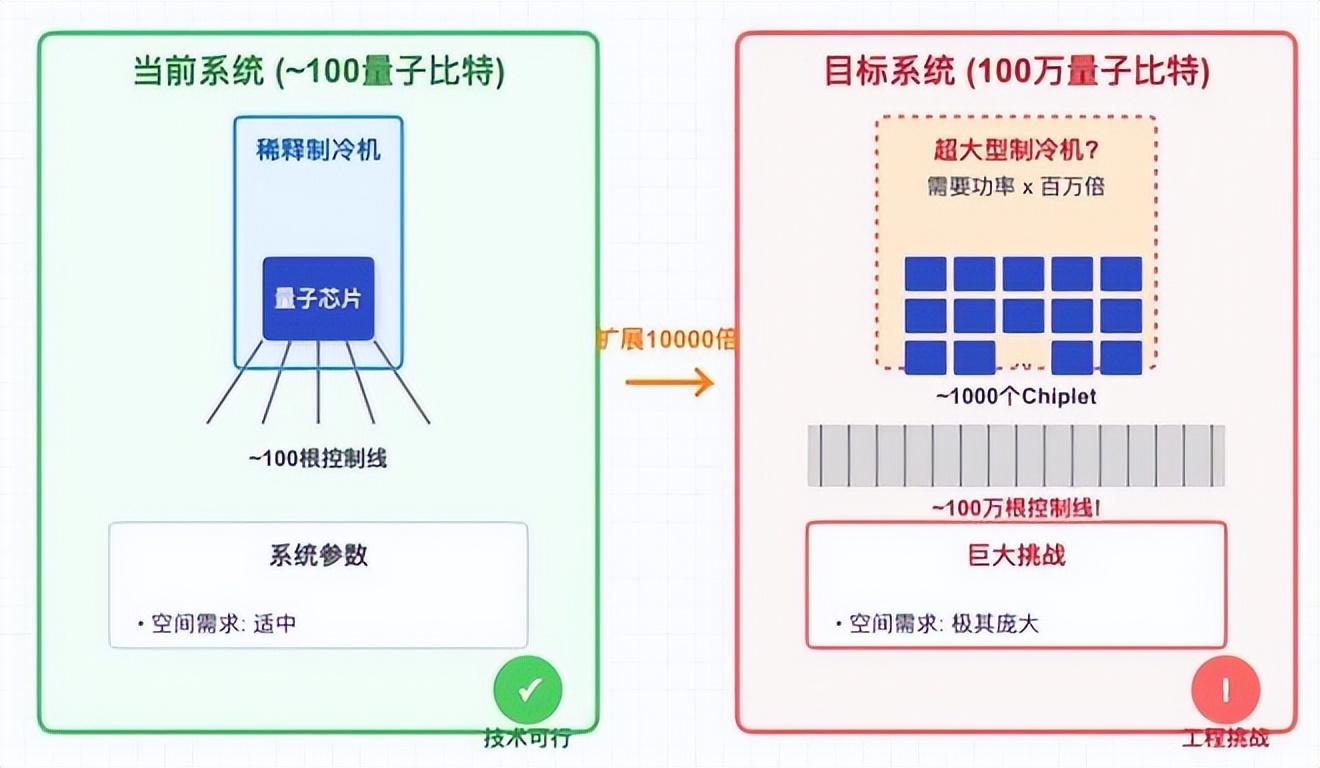

這種方式目前大致可以支撐數百個物理量子比特。但如果要構建百萬級量子比特(比如由數千片、每片數千比特的chiplet組成),問題就顯現出來了:每個量子比特都需要對應的導線、衰減器、濾波器,數量會隨比特數近似線性增加。

雖然單根導線的熱泄漏量不大,但當導線、濾波器數量擴展到百萬量級時,累積的熱負載將遠遠超過製冷機的極限。當然,應對這一挑戰,除了需要研發功率更大的稀釋製冷機外,也需要探索如何利用多路複用技術、低溫 CMOS 電路以及低溫超導電子學來降低佈線與能耗開銷。

總之,現有稀釋製冷機的製冷功率和物理空間都嚴重不足。要支撐百萬比特的系統,製冷機的功率至少需要提升百萬倍以上。但這種超大功率、超大體積的稀釋製冷機目前還不存在。

圖3從百比特到百萬比特,製冷系統的擴展性挑戰

如果採用chiplet設計 +低溫片間互聯的方案,那麼製冷系統就是一道必須跨越的工程大關,所需的研發投入極爲龐大(很可能在數十億美元量級)。

量子比特控制系統

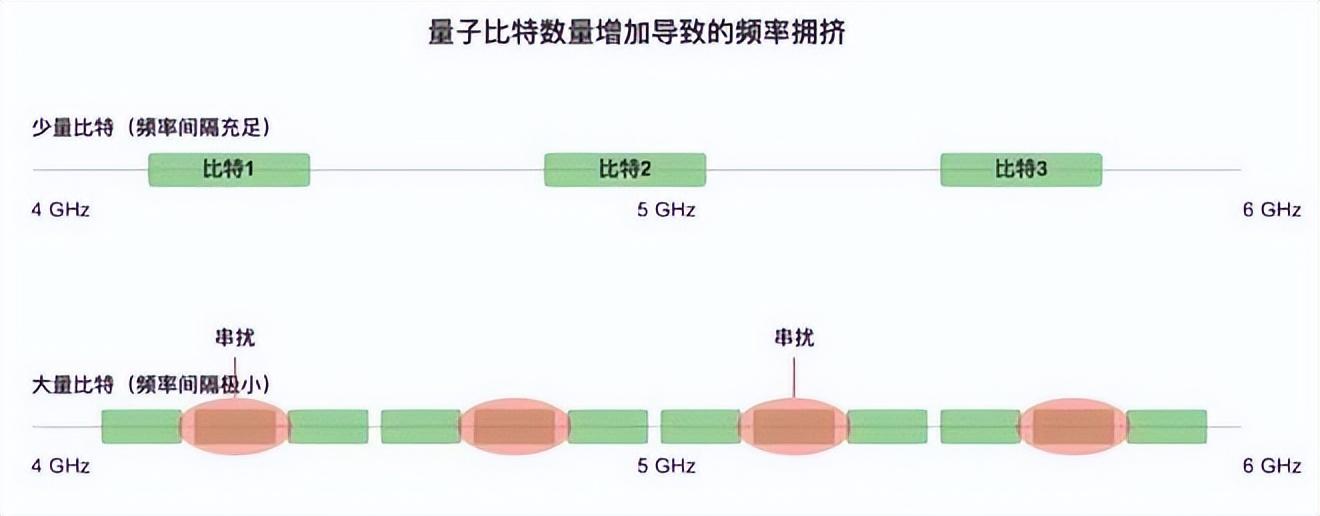

如前文所述,每個超導量子比特都需要用微波信號來進行控制,並且不同的比特必須分配到不同的控制頻率。隨着量子比特數量從數百擴展到數百萬,控制系統會面臨幾個明顯的挑戰:

·頻率擁擠:微波的頻譜範圍是有限的,比特數增加後,頻率間隔被迫減小。相鄰頻率太接近時,控制信號可能互相干擾,造成串擾問題。

圖4 相鄰頻率太接近時,控制信號可能互相干擾,造成串擾問題。

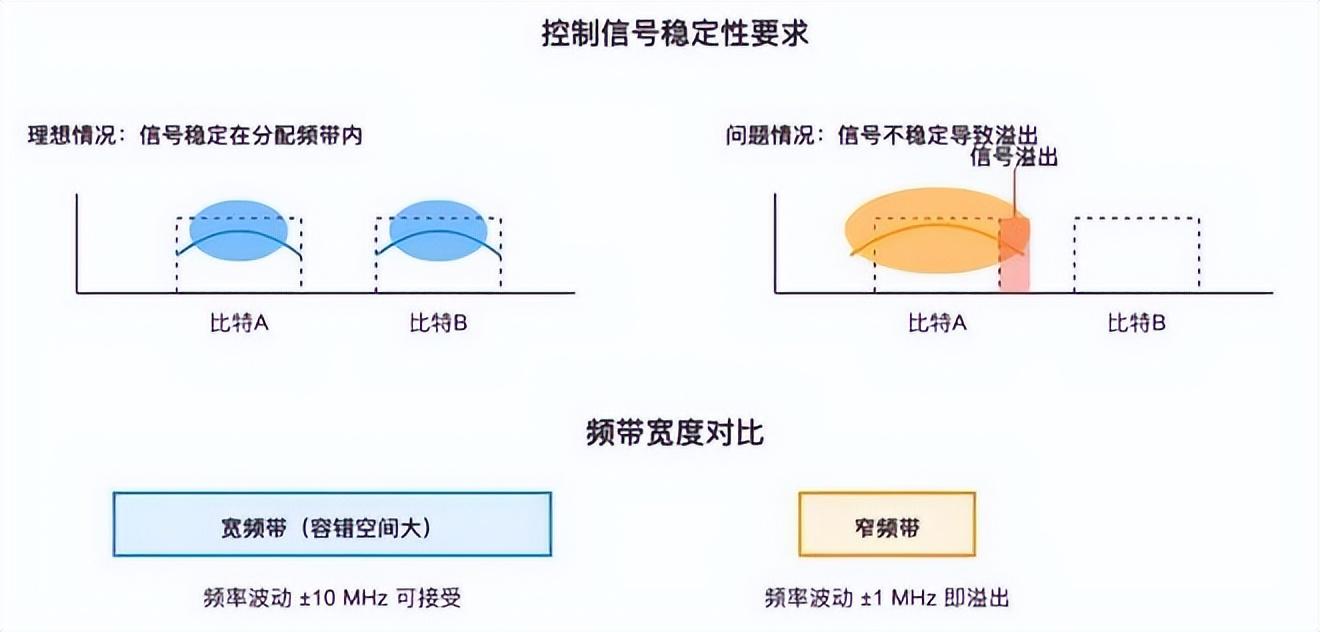

·精度要求提高:頻帶變窄意味着控制信號必須更加穩定,否則會“溢出”到相鄰比特。對頻率穩定度和相位噪聲的要求變得更嚴格。

圖5 頻帶變窄後,對控制信號的頻率穩定度和相位噪聲要求大幅提高 微小的頻率漂移都可能造成信號溢出到相鄰量子比特

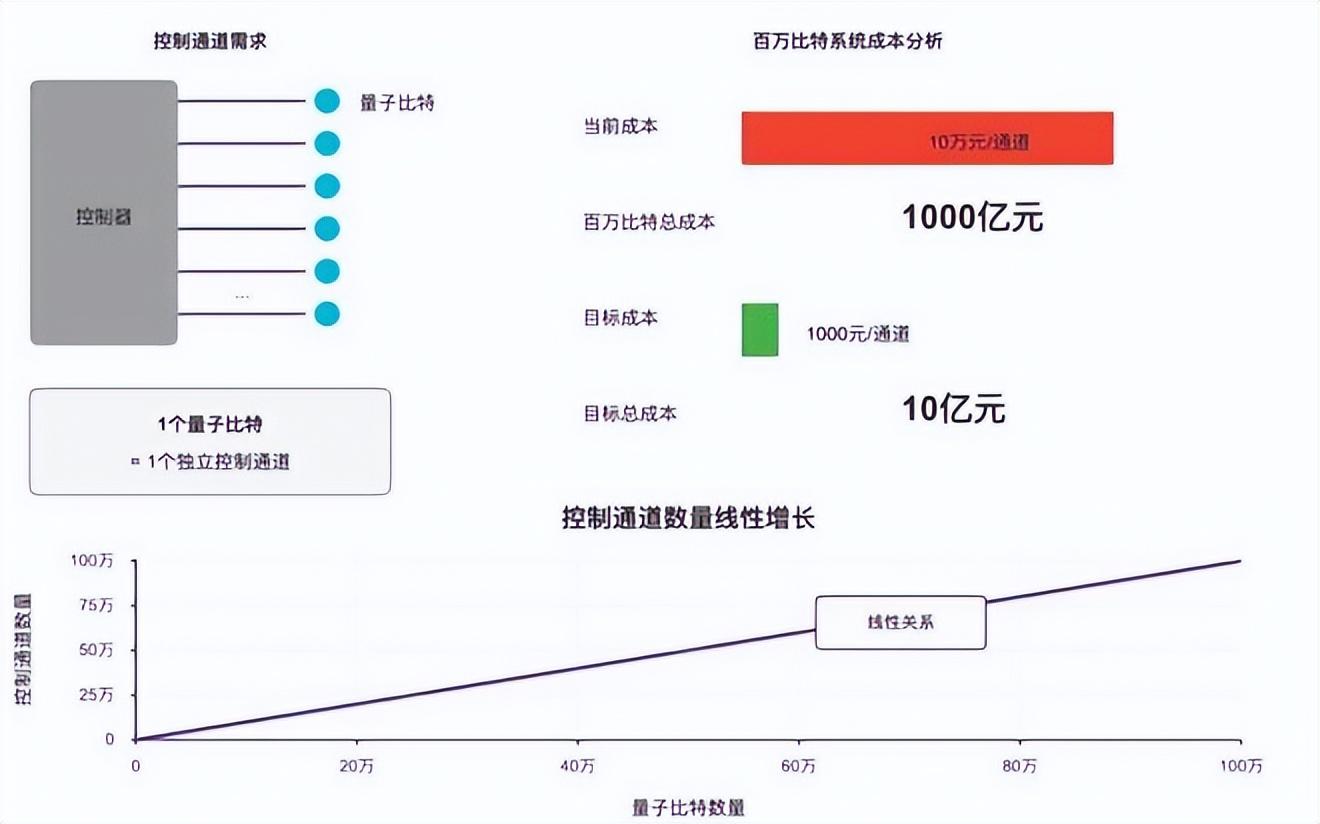

·控制複雜度飆升:每個量子比特都需要獨立的脈衝控制(幅度、相位、時序)。如果有百萬個量子比特,就意味着要有百萬個獨立控制通道。目前一個通道的硬件成本大約在 10 萬元/個,長遠目標是降到 1000 元/個,否則成本無法承受。

圖6 如果有百萬個量子比特,就意味着要有百萬個獨立控制通道

這些問題本質上都是工程瓶頸。在小規模系統裏已經顯現,規模擴大後複雜度呈現線性增長。

不過,這一方向的挑戰相比其他問題而言,業界普遍認爲相對樂觀,原因主要有:

·頻率擁擠的規律:實驗表明,在幾十比特範圍內(大約 60 比特以內),頻率分配的複雜度增加較快,但隨着比特數進一步增加,可以通過巧妙的頻率複用和比特佈局,使複雜度趨於可控。因此“頻率擁擠”並不一定是無法跨越的硬障礙。

·門精度要求有限:量子計算並不要求無限精度,只要雙比特門的保真度能穩定在 99.99% 左右,就足以支撐量子糾錯。雖然對控制系統的噪聲要求仍然很高,但這是現有半導技術可以實現的。只是目前能實現這種精度的高速數模轉換器(DAC)成本過高,未來是否能夠依靠大規模製造降低成本仍待驗證。

·硬件成本優化的可能性:目前控制使用的是超導同軸線纜、轉接頭、衰減器和濾波器,這些器件成本高、體積大。一個潛在方向是借鑑半導體產業的 柔性基板工藝,直接在低成本材料上批量製造集成化的低溫佈線,從而顯著降低成本和體積。

控制系統就是另一道必須跨越的工程瓶頸:百萬量級量子比特需要百萬獨立控制通道,頻率分配、信號精度和成本壓降都是關鍵難點,雖然相對其他方面的問題更加樂觀,但依然需要長期的工程投入與技術迭代。

糾錯系統

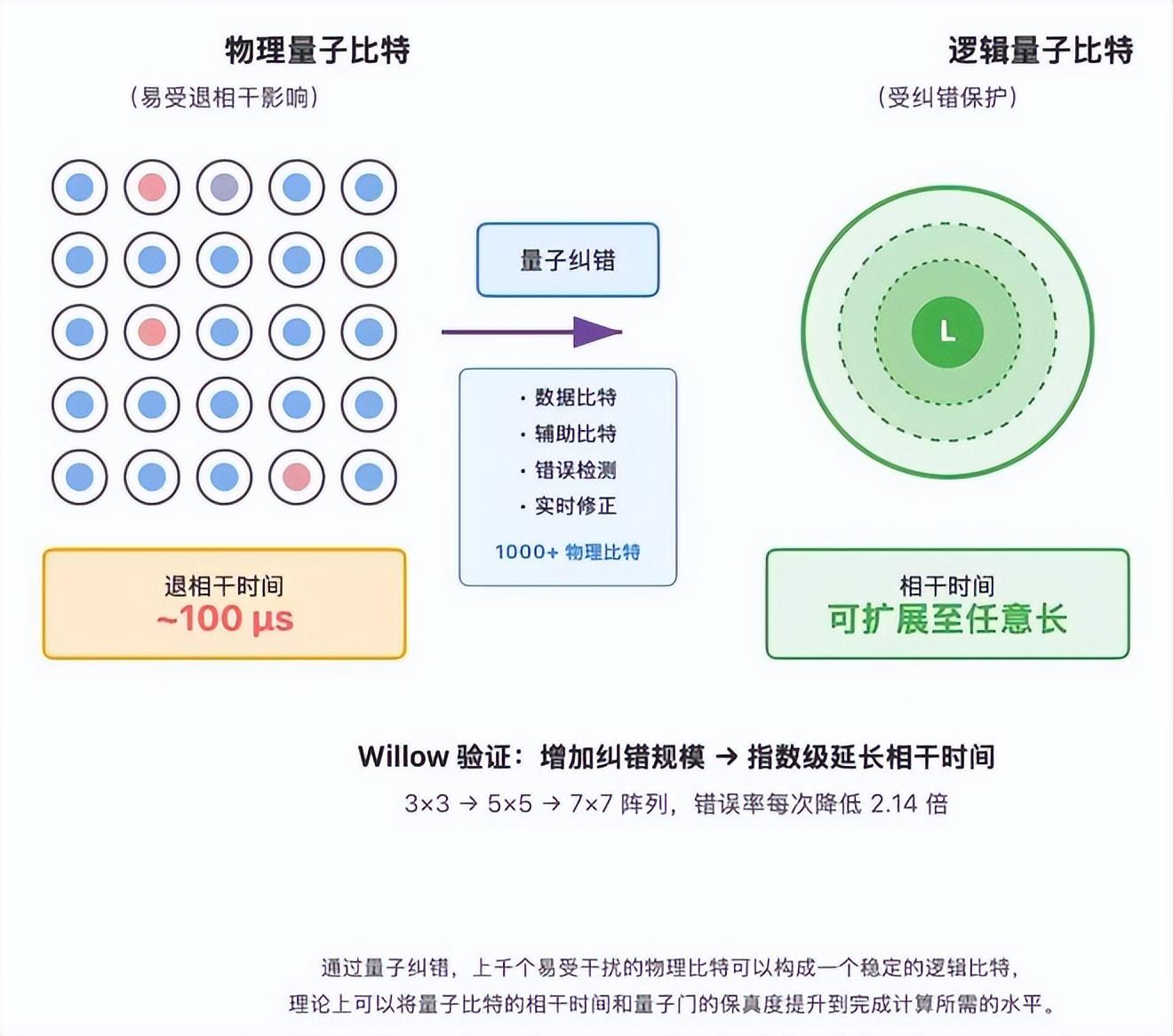

要讓量子比特和門保真度滿足完成像分解 RSA 這樣的大規模計算的要求,就必須依靠量子糾錯:用上千個物理比特來構成 1個邏輯比特。

量子糾錯的理論框架已經成熟,能夠顯著提升邏輯比特的相干時間和門保真度。例如谷歌在Willow 項目中,就展示了通過糾錯方法獲得更穩定的邏輯比特。

在 Willow 處理器中,一個邏輯量子比特並不是由單個物理比特直接表示,而是由一個二維物理比特陣列共同編碼。陣列中包含兩類比特:

·數據比特:用於承載邏輯量子態;

·輔助比特:通過週期性操作來檢測數據比特之間是否出現了錯誤。

這些輔助比特的測量結果不會直接揭示邏輯態本身,但能反映出系統中是否發生了位翻轉或相位翻轉等錯誤。結合解碼算法,系統可以判斷錯誤發生的位置並進行修正。

在 Willow 的實驗中,研究人員首次在硬件上驗證了這樣一個關鍵特性:當物理比特的誤差率降低到閾值以下時,只要工程上允許,理論上可以通過持續增加編碼規模來持續延長邏輯量子比特的有效相干時間,並持續提高邏輯門的保真度。換句話說,相干時間和門保真度的最終限制主要來源於工程資源,而非基本物理定律。

圖7多個易受干擾的物理比特可以構成一個穩定的邏輯比特, 理論上通過擴大用於糾錯的物理量子比特的規模可以將相干時間延長到完成大規模量子計算所需的任意時長。

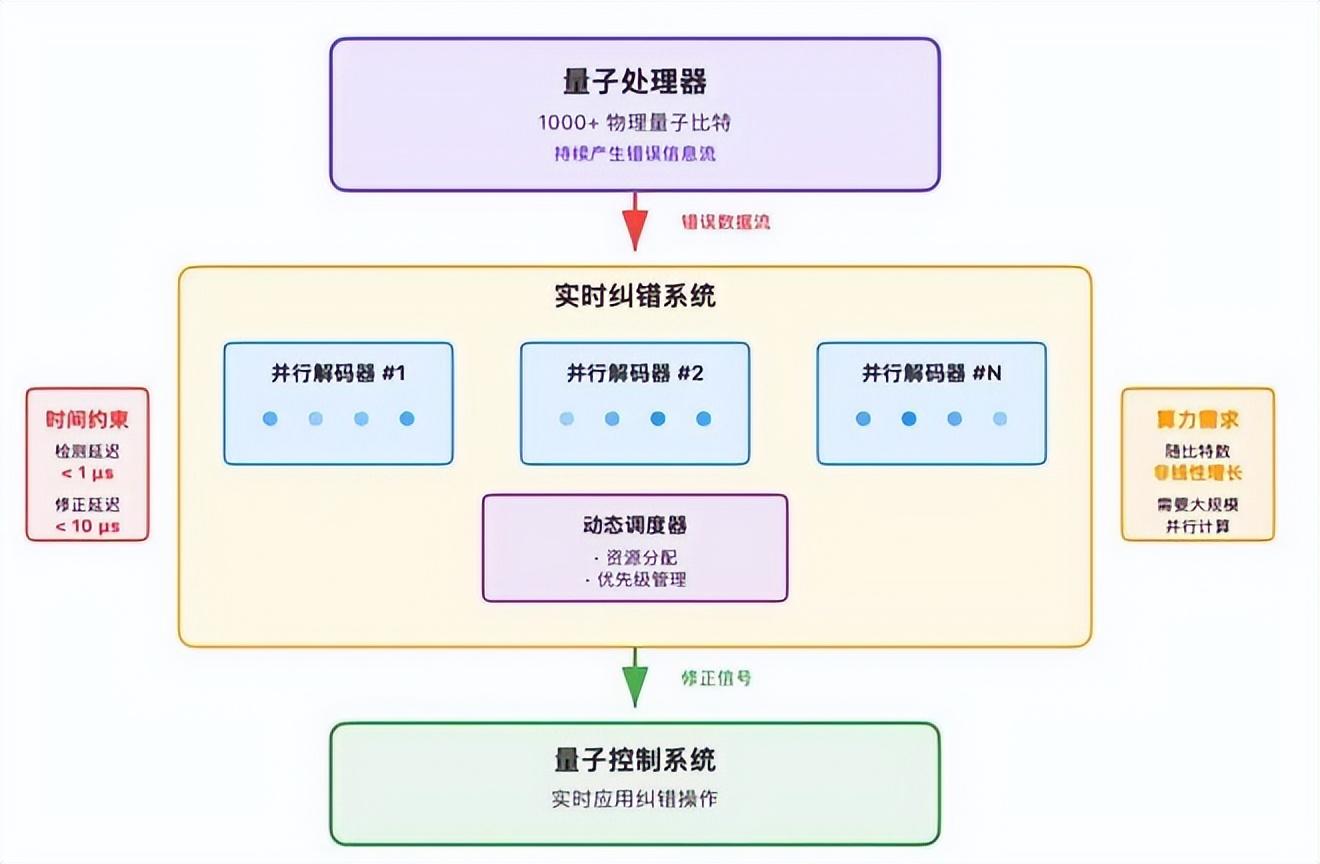

不過,在工程實現上,解碼算法必須是實時的:如果錯誤累積過快,將超出可恢復範圍。隨着比特數量增加,糾錯開銷呈非線性增長,對經典硬件提出極高的算力和延遲要求。好在糾錯計算本身可以高度並行,理論上可以通過增加算力(即“堆錢”)來緩解瓶頸。

挑戰不僅在物理層面,還在於軟硬件一體化工程:由於量子比特持續產生隨機錯誤無法在運行前預知,電路必須根據現場檢測到的錯誤信息動態調整後續操作。同時,糾錯系統還要實現邏輯比特的實時調度與校準,並在極低延遲下完成並行解碼。這些要求疊加在一起,使得容錯量子計算不僅僅是一個硬件難題,還是一個規模極大、複雜度極高的系統工程。

圖8量子糾錯不僅是物理問題,更是極具挑戰的系統工程: 需要在微秒級時間內完成錯誤檢測、並行解碼和實時修正,算力需求隨系統規模非線性增長,但可通過增加硬件資源("堆錢")來解決。

量子糾錯系統就是最後一個必須跨越的門檻:它要求上千物理比特組成 1個邏輯比特,並依賴實時、並行的糾錯與動態調度,這對軟硬件一體化提出極高要求,是極具挑戰性的系統工程。但整個過程沒有無法解決的科學上的限制,更多是系統工程的挑戰。

綜上所述,要製造出高性能的量子比特計算機,除了量子芯片技術的突破,也離不開其他系統的支持。真正的難點在工程層面,包括冷卻、控制、佈線、能耗以及量子糾錯的實時實現。隨着規模擴展,這些問題會呈現非線性放大,尤其是串擾、糾錯開銷和能耗,但在一定規模後可通過模塊化設計和片間互聯讓複雜性進入區域線性階段。總體而言,雖然沒有科學上的“死衚衕”,但工程 gap 極大,需要長期積累和鉅額投入。

策劃製作

本文爲科普中國·創作培育計劃扶持作品

出品丨中國科協科普部

監製丨中國科學技術出版社有限公司、北京中科星河文化傳媒有限公司

作者丨李冠成騰訊玄武實驗室負責人

審覈丨欒春陽 國防科技大學理學院

策劃丨張林林

責編丨丁崝

審校丨徐來、張林林