如果不法分子利用Sora造謠傳謠,我們該如何識別?

最近,美國人工智能研究公司OpenAI的文本生成視頻大模型Sora備受關注。但在被認爲人工智能技術取得新進展的同時,擔憂也隨之而來:如果不法分子利用Sora造假、造謠,普通人又如何識別呢?

目前的Sora並不完善,有些視頻因爲邏輯錯誤,能夠輕易辨別——紅酒杯掉在桌面上,杯子沒有碎,酒已經灑了一桌;考古學家挖掘出一把椅子,椅子自己開始跑動……但從OpenAI發佈的多段樣片看,“以假亂真”的案例更多,包括討論最多的那段走在東京街頭的時尚女郎,不論是背景中的城市,還是女主角臉上的雀斑、墨鏡裏的倒影等細節,幾乎無懈可擊,靠肉眼完全無法辨別是拍出來的還是人工智能生成的。

於是,有人提出假設:如果用人工智能技術看Sora的視頻,能不能識別出來呢?

圖片來源:Sora生成視頻截屏

圖片來源:Sora生成視頻截屏

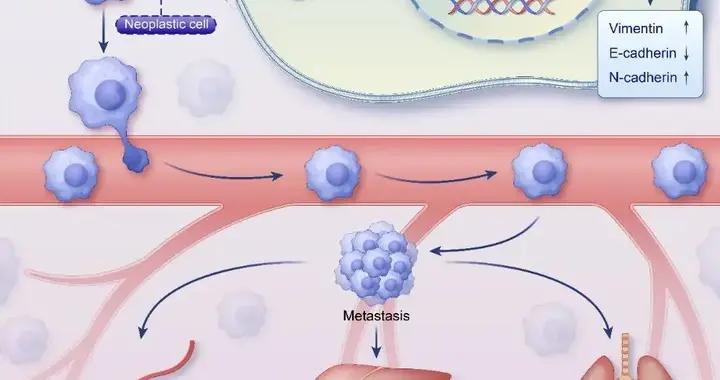

一個案例是讓谷歌發佈的人工智能大模型Gemini 1.5觀看並分析 Sora 生成的視頻。在觀看完一段主題爲“櫻花雪景”的視頻後,Gemini 判斷這段視頻是假的,理由如下:櫻花一般在春天開放,那時不下雪;雪下得太均勻了;雖然是下雪天,但視頻中的人物穿得很單薄。

Gemini給出的理由未必都站得住腳,不過提供了另一種思路:面對人工智能造假,技術打假變得越發重要。

“有視頻有真相”成爲歷史

Sora的發佈,意味着“假消息”“假新聞”正不斷迭代。所以,對那些習慣於從短視頻平臺獲取信息的網友來說,真的不能再隨意相信那些視頻了。

目前,很多人關注Sora在電影等娛樂內容生產上的應用,可實際上它也會改變新聞的生產方式和流程。眼下,用技術炮製的“假新聞”層出不窮,已經改變了很多慣有理念:圖文時代,人們認爲“有圖有真相”,結果發現圖可以P;視頻時代,很多人覺得“有視頻有真相”,但在出移花接木等造假手段上,如今又出現了Sora,用人工智能直接生成視頻,連原始素材都不在需要。

據此,中央民族大學新聞與傳播學院教授郭全中認爲,Sora的出現導致視頻生產門檻大大降底,新聞倫理會受到很大沖擊。

合合信息圖像算法研發總監郭豐俊也指出,隨着人工智能技術的發展,深度造假(Deepfake)帶來的治理危機將更加明顯。所謂“深度造假”,是指基於深度學習等機器學習方法,創建或合成視聽覺內容,如語音模擬、圖像、音視頻、文本等。所以,不論是已經出現的AI換臉,還是Sora,都可以看作深度造假的典型應用。

新技術、新應用雖然能幫助很多行業擺脫簡單或重複的勞動,或者讓創新靈感變得更加容易實現,但也會產生一定的負面影響。比如,別有用心之人利用深度造假技術,能更輕易地盜用他人身份、編造相關信息,實施商業詆譭、敲詐勒索、網絡攻擊和犯罪等違法行爲。再比如,不法分子藉助深度僞造技術,散佈虛假視頻,激化社會矛盾,煽動暴力行動,威脅國家安全和公共安全等。

可見,Sora是一把雙刃劍。管理部門、業界應當注重針對相關技術的監管,而對普通人來說,也要有所警覺:“有圖有真相” “有視頻有真相”都已經成爲歷史。

“打標籤”有幫助嗎?

如果肉眼無法分辨視頻真僞,那有什麼辦法來區分呢?

就目前業界的探索看,“打標籤”似乎最簡單、最直接。

多名社交平臺從業者表示,不論國內外,現有的法律法規都沒有禁止人工智能生成的內容在社交平臺傳播。事實上,從技術的角度看,平臺也未必有能力判斷相關內容是“人工智能生成的”還是“真實拍攝的”。所以,眼下各平臺的普遍做法是要求發佈者對這類生成內容打標籤,而且不僅僅涉及大模型生成內容,還包括那些擺拍、編劇、剪輯的作品,都要打上標籤。

作爲大模型的開發者,谷歌和OpenAI也在研究“打標籤”——通過後臺設置,爲所有通過網絡其大模型生成的內容打上水印,告知用戶。

然而,“打標籤”或“打水印”無法從根本上解決深度造假的問題。

一方面,按照目前社交平臺的治理方式,有相當一部分“打標籤”行爲得依靠發佈者。從上海闢謠平臺澄清的謠言看,其中不乏斷章取義、移花接木、擺拍編造的作品,但拍攝者和發佈者並沒有打上相關標籤。

可見,就治理成果而言,“打標籤”並沒有將造假行爲一網打盡。雖然有的視頻經過平臺自治或網友舉報被標記、刪除,但仍有大量假視頻、假消息。

另一方面,即使大模型開發企業通過技術設置,使得大模型生成的文字、圖片、視頻等被強制“打標籤”、告訴公衆它們來自人工智能而非現實,但從現實傳播看,相關標籤、水印可能在分享中被人故意抹除,截屏、錄屏、二次剪輯加工等,都可以輕鬆去除標籤和水印,從而使得公衆越發難以識別。

如此看來,“打標籤”只是防範深度造假的初步手段或基礎手段,效果未必理想。或許是出於這一考慮,OpenAI在公開介紹Sora時也承認,該模型還存在一些安全風險,所以暫時不會面向公衆開放。

“用魔法打敗魔法”

那麼,有什麼方法能更加精準地識別深度造假呢?

Gemini對Sora生成內容的真假判斷,提供了另一條思路——用人工智能識別人工智能。不少業界人士將此比喻爲“用魔法打敗魔法”,認爲通過技術手段,有機會從根本上識別深度造假並降低相關風險。

OpenAI也表示,正在進行相關研究,包括研發能檢測誤導性內容的文本分類器、圖像分類器等,“在OpenAI產品中,我們的文本分類器會檢查並拒絕違反使用政策的文本輸入,包括涉及極端暴力、性、仇恨、名人肖像、他人IP等內容,並進行相關提示。我們還開發了強大的圖像分類器,用於審查生成視頻的每一幀,以確保它在向用戶顯示前,符合我們的使用策略。”

不過,這些仍能看作企業的自律行爲。就整個行業來說,來自第三方的“魔法”同樣重要——因爲內容生成企業的“規範”建立在該企業自身的價值基礎上。如果研發企業本身“做惡”,如何指望“自律”行爲能防範風險呢?

正因爲此,很多第三方企業與機構開啓了“鑑別深度僞造”技術的研發之路。

郭豐俊介紹,國內外已有不少企業專注於鑑別人工智能篡改,其中包括大量中國企業,如中國電信等央企,瑞萊智慧(RealAI)、 中科睿鑑等大專院校與科研院所孵化的科技公司,以及網易,合合等深耕人工智能行業多年的技術企業。總體而言,國內科研團隊在鑑別深度造假方面的成績已經處於世界先進水平,多個國內研究團隊曾在國際知名的篡改檢測大賽中獲得好成績。

更積極的成果在於“用魔法打敗魔法”在國內已經有落地案例。他舉例,比較典型的是在金融領域,已有不少金融機構利用國內技術企業自主研發的人工智能甄別僞造人臉圖像技術,來判斷相關人臉圖像是真實的還是合成的,或者被AI換臉。這一技術主要應用在銀行及金融行業的客戶圖像、視頻真僞檢測上,能避免身份盜竊和欺詐,保護財產安全。

不過,業內人士也指出,“用魔法打敗魔法”依舊任重道遠。隨着深度學習和計算機視覺等領域技術的不斷進步,篡改甄別技術需要不斷升級並拓展應用場景。在這個過程中,需要更多的企業、社交平臺參與,共同爲“科技向善”努力。

微信編輯:何夕

還原事實,洞悉真相。

歡迎關注,留言舉報!