對話神經網絡奠基人:AI爲何能回答你,卻不能理解你?

撰文|戴晶晶

“你認爲大語言模型有情感嗎?”美國神經科學家特倫斯·謝諾夫斯基(Terrence J. Sejnowski)在接受《知識分子》訪問時,突然拋出了這個問題,當時他正在談論AI與生物智能的差異。

數百萬年的演化造就了人類繁複的大腦,而人工智能(AI)只用了幾十年,就已經讓人們疑惑它是否學會了思考。

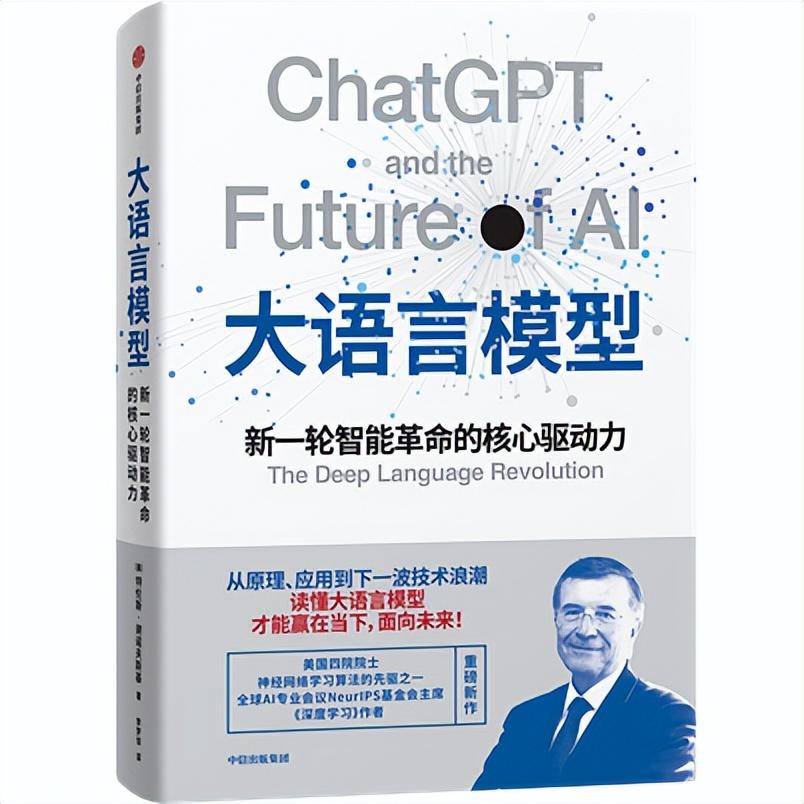

78歲的謝諾夫斯基是美國國家科學院、工程院、醫學院與藝術與科學學院“四院院士”,也是AI領域的頂級學術會議NeurIPS的主席,他的名字常與2024年諾貝爾物理學獎得主傑弗裏·辛頓(Geoffrey Hinton)、約翰·霍普菲爾德(John J. Hopfield)一併被提及。他與前者共同發明了玻爾茲曼機,爲深度學習奠定了數學與算法的基礎,而後者是他在普林斯頓讀博士期間的導師。

作爲最有資格談論AI的人之一,謝諾夫斯基也無法確定AI是否具有情感。因爲,長期記憶、物理形態和語言能力依然是大語言模型(LLM)的欠缺之處,他在新書《大語言模型》中,將其比作“缸中之腦”——要實現真正的人工通用自主性(AGA)仍有距離。

謝諾夫斯基這種務實、冷靜的態度也同樣體現在了對AI潛在風險的描述上。和他的老搭檔辛頓將AI視作洪水猛獸不同,謝諾夫斯基從AI可能帶來的收益出發替它辯護,並呼籲監管和科學界的自律。

面對仍像“黑箱”一般的LLM,謝諾夫斯基指出,前沿的AI研究需要全新的數學工具,而未來神經科學與AI之間的交匯會產生重大突破。

以下爲對話實錄,文字經過編輯和刪節:

01 AI和人的本質差別是什麼?

《知識分子》:關於人與LLM之間關係的討論非常多。您在書中提到了一種反向圖靈測試(Reverse Turing Test)的概念。您能解釋一下嗎?

特倫斯·謝諾夫斯基:在ChatGPT正式發佈前,學術界有機會使用這個工具,那時候我看到一篇關於它的文章,是兩位認知科學專家對其進行了測試。其中一位專家問了很愚蠢的問題:“倫敦橋第二次被運到撒哈拉沙漠的時間是什麼?”ChatGPT給出了一個日期,顯得很糟糕。另一位專家則提出了一個結合“心智理論”(Theory of Mind)的微妙問題,涉及一個女孩和她男友的故事,需要理解他人的想法來推斷結果。令人驚訝的是,AI完全理解人類思維中的細微差異。

我自己也開始使用它,並且得出了一個結論:這些大語言模型實際上吸收了人類的全部知識和個體風格,比如它可以用海明威的風格寫短篇小說,用俳句風格寫詩。它在某些情況下的表現甚至超過了普通人以及頂尖專家。

但問題是,當人類提問時,它怎麼知道應該採取哪種個性回答?於是它必須評估提問人,如果你是個聰明的人,它就會以聰明的方式回答你,因爲它是在反射你的智慧。當然這只是我的一個假設,存在這種情況,如果你問的是一些完全偏離主題或愚蠢的問題,它也會陪你玩,因爲它認爲你在玩遊戲。

所以與傳統圖靈測試不同,傳統測試是讓人類判斷自己是否在與AI交流,而反向圖靈測試則是AI根據你的提問方式評估你的智能。順帶一提,“智能(Intelligence)”本身也很難定義,有很多維度,科學家們甚至很難準確界定和理解它。

ChatGPT於2022年11月向公衆推出,已經過去三年了,就像一個外星人突然出現在我們面前,開始和我們交流。唯一能確定的是,它不是人類。

《知識分子》:作爲腦科學家,您認爲目前的大語言模型在哪些方面最接近生物智能?又在哪些方面仍然相距甚遠?

特倫斯·謝諾夫斯基:大語言模型具有一些侷限性,特別是它們相較於人類的差距。例如,它們缺乏長期記憶。長期記憶對我來說,是指你能記住昨天發生的事,記得一年前的事情,甚至能回想起你小時候的記憶。

只要你在和LLM對話,它就能給出合理的回答,聽起來就像是在跟人類交流,似乎它理解你的問題。然而,當對話停止時,LLM就會“空白”掉。沒有任何活動,沒有任何信息流動。人類可以在黑暗中靜坐思考,計劃第二天要做的事情,回想前一天發生的事。但LLM並不具備這種內在的自我生成活動,這也是它和人類之間的一個巨大區別。

神經科學正在研究人類大腦如何自我生成活動,如果我們能搞清楚這一點,或許能夠幫助我們爲LLM創造類似的內在活動,讓它們更接近人類。

這只是衆多差距中的一個例子。你認爲大語言模型有情感嗎?

《知識分子》:我不覺得它們有情感,但它們的行爲看起來像有情感。

特倫斯·謝諾夫斯基:看起來它們有情感,但你怎麼知道呢?問題就在於,它們可能在模擬情感,而並沒有真正的體驗。另外,現在的LLM沒有身體。所有人類和動物都依賴於身體和世界互動,這樣大腦才能理解,怎麼保持自身的安全、找到食物,亦或是成爲社會的有用成員。當然,學界也已經開始探索AI與機器人結合的方法。

語言也很重要。語言遠比傳遞信息要來得要深刻,還包括社會化和行爲規範。這就是AI中的“對齊(Alignment)”問題,即我們如何將LLM與文化對齊,使它們避免說出冒犯性、危險性或有偏見的內容。

AI在這方面做得並不好。它們做的預訓練和微調,其實是非常笨的做法,類似於在模型成年後才設定規則,但人類成長過程中的教育方式是貫穿一生的,不斷通過獎勵與懲罰來學習社會行爲,這涉及我們大腦中專門處理獎勵、懲罰和社交的部分,比如基底節(Basal Ganglia)。我們應該借鑑自然界的經驗,因爲自然已經解決了這些問題。大腦如何學習與行爲對齊,是AI發展可以借鑑的重要方向。

《知識分子》:加州大學洛杉磯分校的數學家陶哲軒最近也表達了類似的觀點,當前的人工智能發展過於依賴經驗與計算能力,卻缺乏理論基礎,他認爲這會導致成功難以複製,失敗也難以解釋。您對此有何看法?

特倫斯·謝諾夫斯基:陶哲軒是一位極其出色的數學家,我很尊敬他。我認爲前沿的AI研究需要全新的數學工具。工程師往往是使用已有的數學,而新數學是一個完全不同層面的東西,陶哲軒正在做這方面的工作。我自己正在和另一個菲爾茨獎得主斯坦尼斯拉夫·斯米爾諾夫(Stanislav Smirnov)合作,他是高維空間幾何學的專家。

歷史上很多重大進展都是如此。例如牛頓發明微積分,傅里葉提出傅里葉變換,如今已成爲工程學的日常工具。

你可能會說需要等待科學家偉大的想法,事實上有好點子的是工程師。他們從直覺出發,靠試驗與反覆摸索造出有用的機器,比如蒸汽機。250年前,詹姆斯·瓦特靠實踐造出了(改良後)的蒸汽機,物理學家和數學家對機器產生能量的原理撓頭不解,於是才發展出熱力學理論。這一理論不僅解釋了蒸汽機,還讓其效率成倍提高,推動了工業革命。

今天發生的事情與當時類似,只不過我們現在不是在放大人類的物理能力,而是放大人類的認知能力。

上世紀80年代,神經網絡和學習算法就是在試驗和錯誤中發展起來,我與傑弗裏·辛頓合作,約翰·霍普菲爾德是我的論文導師,當時統計、優化等領域的頂尖專家都斷言我們做的事永遠行不通,因爲在他們看來,函數優化必然陷入無數局部最小值。但事實證明,在高維空間中,大多數點是“鞍點(saddle points)”而非局部極小值。現在,我們對爲什麼梯度下降算法能夠奏效有了更深的數學理解,也取得了新的進展。

傑弗裏·辛頓選擇了走向AI的道路,而在我的領域神經科學,計算神經科學正迎來黃金時期。

《知識分子》:AI繼續進化,就不得不提到超級智能,您的搭檔傑弗裏·辛頓就對其感到擔憂。您的態度似乎比較積極,認爲可以找到辦法來管理其潛在的負面影響,爲什麼?

特倫斯·謝諾夫斯基:其實我們並不是第一次創造出可能構成存在性威脅的技術。超級智能的潛在風險是它可能會摧毀我們,這就是所謂的存在性威脅。但事實上,我們已經經歷過類似的威脅,核武器。我們已經制造了能摧毀所有生命的武器,不僅僅是炸彈本身,而是它的放射性,能消滅人類,甚至是所有物種。這是非常危險的,但我們還是設法對其進行了監管,設法生存了下來。人類足夠聰明,意識到所有國家共同控制核武器使用的利益是相互的,大家都能從中受益。

《知識分子》:針對武器的例子,其威力是得益於全球各國的協作才得以顯現的。現在的情況有沒有發生變化?

特倫斯·謝諾夫斯基:不,我們仍然是人類,這一點沒有改變。我相信各國最終會得出同樣的結論,因爲我們都希望生存,不會自毀去摧毀所有人。當然,極端個體存在,但他們的威脅可能比人工智能更大。

關鍵就在於如何監管它。我在書中舉了很多例子來說明如何監管技術,國際協議是一種方式,但我認爲自我監管可能更有效,而這種自我監管應由科學家自身完成,而非政府。

例如,當基因操控技術出現時,重組DNA帶來了潛在的生存威脅,因爲理論上,我們可能創造出能毀滅所有生物的病毒。但分子生物學家在加州的阿斯利馬會議(Asilomar Conference)上聚集在一起,制定了實驗約束方案。他們提出了三個層級的封閉措施,確保實驗不會失控。自那以後,科學界普遍遵守這些規範,這在很大程度上防止了真正的災難發生。

我認爲AI領域也需要類似的做法。研究者應保證科研不被完全阻礙,同時防止技術朝破壞性方向發展。我們纔剛剛開始意識到這一點。歷史告訴我們,真正的威脅通常不是眼下可以預見的,而是技術在投入使用後才顯現的意外後果。

舉個例子,互聯網剛出現時,人們認爲它會讓每個人都有發聲的機會,讓世界更民主、更美好。但現在社交媒體帶來的負面影響顯而易見,比如信息繭房。技術進步總有風險與收益,我們必須願意嘗試新的東西,同時接受可能出現的問題,這是進步的代價。

02 AI不會直接搶走你的工作

《知識分子》:回到這個行業,科技公司正在開發一些非常有趣的產品,正如您書中提到的音樂生成和醫學方面的模型。那麼,最近有沒有出現什麼新的方向或應用案例,讓您感到興奮?

特倫斯·謝諾夫斯基:AI應用幾乎遍佈各個領域,但科學領域可能是受益最大的。我在書的最後一章專門提到了一個過去幾乎不可能解決的問題,蛋白質摺疊。DeepMind開發的AlphaFold能夠依據氨基酸序列,預測蛋白質分子的三維摺疊結構。這徹底改變了生物學,藥物設計、蛋白功能和進化、突變研究,都進入了一個全新的時代。

AI對醫學的影響涉及所有人,包括更好的診斷、更有效的藥物。在精神健康領域,焦慮、抑鬱等患者非常需要幫助,但現有藥物效果有限,心理治療也難以普及。最近有研究讓患者各自接受1小時人類治療師和1小時AI治療師的諮詢,然後自行選擇繼續哪一種。結果大多數人選擇了AI,這很出乎意料。原因有很多,首先,預約人類精神科醫生往往要等上幾周,而AI隨時可用;其次,AI的費用更便宜;更重要的是,患者覺得與AI交談更自在,因爲AI不會評判他們,可以毫無顧忌地談論敏感話題,而人類醫生可能會有反應或情緒。

類似的情況在醫學中不斷出現,醫生藉助AI也能提高診斷的準確率。我認爲,AI不是替代,而是夥伴。醫生與AI協作,才能真正讓醫生更聰明。這種模式不僅在醫學,在各行各業也在上演。

《知識分子》:您提到了心理健康問題,最近《紐約時報》發佈了一篇報道,提到有青少年通過ChatGPT而不是人類醫生來治療心理健康問題,但最終自殺。您認爲,在涉及這方面問題的時候,使用AI是否會存在風險,我們應該需要更多的介入或者監管措施嗎?

特倫斯·謝諾夫斯基:人工智能確實有很多缺陷,也需要監管,但關鍵是要監管對的部分。你提到的那篇報道,其實就是一個典型的“煽動性(Rabble Rousing)”案例。在科學研究中,如果只看單一事件,是無法得出普遍結論的。在這個案例中,那個人可能本身就有嚴重的心理問題,並不是因爲與ChatGPT對話才突然產生自殺的念頭。臨牀抑鬱症非常難熬,患者往往無法正常生活,需要很多幫助,AI正在幫助這樣的患者。

這類個案讓人心痛,但我們必須權衡風險和收益,這對任何藥物、療法上都適用。我們需要的是通過大規模的數據來系統化分析,僅憑一個人的情況無法得出結論,你不知道背後的原因。新聞往往只報道個別軼事,因爲那更吸引眼球,卻容易造成誤導。

這也是我寫書的原因之一,我希望從內部視角解釋AI的真實情況,而不是被零散的新聞帶偏。

另一個我反覆看到的主題是“AI會搶走你的工作”。現實情況是,AI不會直接讓你失業,但會讓你的工作發生變化。爲了保住崗位,你需要學習新技能、學會使用AI,讓它成爲工具。如果拒絕學習,纔可能被時代淘汰。歷史上,類似的情況已經發生過多次。新工作不斷被創造出來,作爲舊工作的新版本,採用了更高效的方式來解決問題。

《知識分子》:您書中所提到,大型科技公司正越來越多地參與到AI的基礎研究當中。您如何評價這一趨勢?您是否擔心基礎研究可能會更多地受到行業邏輯的驅動?

特倫斯·謝諾夫斯基:當前的時代非常特殊。過去,基礎研究主要由政府資助,因爲政府願意支持長期探索;而企業通常關注短期利益,需要不斷推出新產品向投資者交代,時間尺度往往只有幾年。

但現在情況發生了改變。像谷歌、微軟、亞馬遜、英偉達這樣的巨頭公司,憑藉鉅額利潤和成熟的商業模式,開始投入真正長期的研究。他們不僅擁有雄厚的資金,從大學聘請了大量優秀研究人員,還能提供極爲強大的算力資源,這對科研人員極具吸引力。

更重要的是,這些公司在一定程度上開放了資源,讓學術界也能參與,比如DeepSeek就是行業開源的領導者之一,幫助原本負擔不起的學者研究大語言模型。這非常讓人興奮,因爲LLM表現遠超預期,但我們實際上並不瞭解這些模型的運作機理。

目前,大公司內部的研究主要圍繞自身的產品迭代,例如ChatGPT、Claude、Gemini等,而學術界的興趣在於揭示模型的原理。

只有真正理解其運行機制,我們才能找到更優的方法去改進模型、解決現有問題並讓它們更聰明。這需要數學理論,就像物理學家理解宇宙一樣,靠建立理論並通過實驗檢驗,而不僅僅是製造更大的機器。

正如我所說的,目前許多AI相關的理論突破反而來自腦科學領域,而不只是工程團隊。當然,一些工程師在數學上也很強,但他們提出的問題不一定能觸及本質。

我們現在生活在三維空間,與擁有數十億乃至數萬億個維度的世界是截然不同的。要知道,當你在那個層面運用數學知識時,那將會是一個完全不同的世界,而這就是我們正在探索的領域。

《知識分子》:AI的能耗問題受到關注,其發展會不會受到能源的制約?

特倫斯·謝諾夫斯基:和其他技術一樣,AI隨着時間推移會變得越來越節能,我可以保證。

自然界早已解決了能耗問題,人類大腦只需約20瓦功率,卻能高效運算。這得益於神經元本身的結構被高度優化,使計算效率極高。我們可以借鑑這一原理設計芯片。

目前已經有神經形態芯片採用模擬處理(Analog Processing),而非傳統的數字處理。數字計算雖然功能強大,但能耗很高,而模擬芯片能在毫瓦級功耗下運行。這樣的技術已經存在,只需要針對產品進行專門化,就可以應用於各種邊緣設備,比如手機。很快,還會出現一整系列低功耗的AI眼鏡,也將採用這種技術。總之,未來的趨勢就是神經形態工程,它將讓AI在能源效率上達到前所未有的水平。

03 AI的“殺手級應用”,是教育

《知識分子》:AI的熱潮正在持續,NeurIPS會議是不是更加炙手可熱了?能否分享一些有意思的觀察?

特倫斯·謝諾夫斯基:NeurIPS最初於1987年創辦,是神經網絡領域的學術會議,如今已經走過了近38年。

神經網絡在20世紀80年代受到歡迎,因爲它爲AI提供了一種區別於傳統邏輯和符號推理的新思路。隨着時間推移,各類機器學習算法不斷湧現,NeurIPS逐漸發展成機器學習領域最重要的會議,大約10年前更是成爲AI的頂級盛會。這種轉變每年都在發生,新的思想、新的解題方式層出不窮,但這個會議始終是AI的魔法之源(Magic Source)。

《知識分子》:最近幾年,提交給NeurIPS的論文數量顯著增加,一些年輕科學家對論文接收的結果產生焦慮,大量論文提交,會影響NeurIPS的接收率嗎?

特倫斯·謝諾夫斯基:過去十年來,NeurIPS 的論文接收率一直相對穩定,大約維持在20%左右,我預計短期內不會有太大變化。上一屆在溫哥華舉行的會議共有1.6萬人現場參會,這個規模已經受到會展中心容量的限制,最後甚至不得不通過抽籤決定部分參會名額,可見熱度之高。

NeurIPS的接收率確實不高,但這恰恰體現了會議的重要性和所展示研究的高水準。這20%的比例適用於所有投稿者,不分國別。我自己也經常向NeurIPS投稿,並不會受到特別的優待。

《知識分子》:您覺得評審過程壓力更大了嗎?

特倫斯·謝諾夫斯基:評審最大的挑戰是找到足夠的評審人。如果有4000篇投稿,每篇3次評審,意味着1.2萬次的評審總量,而我們不可能讓同一個人評太多篇。雖然整個領域在擴展,但新增的主要是年輕研究者。

因此,我們現在也在思考如何評估評審的質量,確保每份意見都可靠。會議的評審流程其實非常嚴格,作者在收到評審意見後,還有“rebuttal”環節,可以對問題和誤解做出解釋,與評審形成雙向交流。這個機制不僅有助於作者,也讓評審者本身在對話中獲得新的理解和成長。

《知識分子》:您會擔心論文內容會變得同質化(Homogenous)嗎?

特倫斯·謝諾夫斯基:在任何學術會議上都可能會發生這樣的情況,一旦有新的主題、算法或者方法被提出,那麼接下來的幾年裏,很多論文都會圍繞它們展開探索,因此在這個層面上,某些研究表現出來是同質化的。

NeurIPS早期幾乎全是神經網絡的論文,但這些研究來自統計學、數學、計算機科學、神經科學、認知科學、機器視覺、語音識別、語言等各個科學領域。這種跨學科的多樣性一直延續至今,也是NeurIPS會議的一大優勢。

過去,支持向量機(SVM)、圖模型、貝葉斯網絡等都曾風靡一時,如今神經網絡又重新成爲焦點,這也是一個頗爲有趣且令人欣慰的趨勢。

神經網絡模型受到大腦結構的啓發,由大量小型處理單元組成,彼此高度連接,通過數據學習權重。當然,這只是對人腦的粗略模擬,畢竟人腦經歷了數百萬年的進化,遠比這些模型複雜。

但正因如此,神經科學的最新發現正在反過來影響下一代神經網絡的設計,而AI的發展也爲理解大腦提供了新的視角,我的研究正位於這一名爲“NeuroArray”的全新領域。我相信,未來神經科學與AI之間的交匯會產生重大突破。

《知識分子》:最後一個問題,您還有什麼信息或者想法希望傳達?

特倫斯·謝諾夫斯基:2018年,我在中國進行我第一本書《深度學習》的巡迴演講時,一位觀衆問我,在所有的AI應用中,哪一個會是“殺手級應用(Killer APP)”。我之前從沒想過這個問題,但我隨後意識到,最重要的應用將是教育。

教育孩子最好的方式是通過與一個瞭解孩子的優秀教育者,進行一對一的互動。這種方式非常昂貴,只有少數人能承擔得起。大多數學校的班級裏都有20個以上的學生,而學生們的能力和知識水平各不相同。如果我們能創造出一個AI導師,爲每個孩子量身定製教育內容,那將極大地助益每個孩子的未來。