手機拍出的高清月亮,可能是“假”月亮?

你可試過用手機拍月亮?月亮一直是中國人核心的審美意象,古人在飲酒賞月中抒懷,留下千古名篇。只可惜當時相機尚未發明,不然我想李白杜甫們一定也很有雅興將相機記錄下來,古今同賞一輪月。

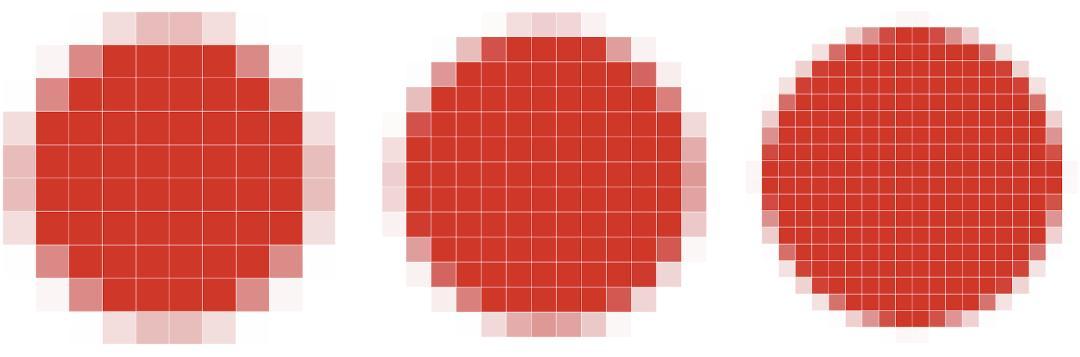

以下三幅圖是筆者拍攝的月亮,使用的設備分別是2011年的某中古機型、2019年的某標準版機型和今年最新的某旗艦攝影手機。三幅圖從模糊到清晰,從抽象到具體,體現了顯像技術的飛速發展。

不同清晰程度的月亮-第一張

不同清晰程度的月亮-第二張

不同清晰程度的月亮-第三張

Hold on!這裏有一個問題:大家不覺得最後一張月亮的照片“清晰”過頭了嗎?從環形山到隕石坑,月亮的陰影紋路看得一清二楚,幾乎已經達到了價值數萬元的長焦鏡頭相機的攝像效果。這是因爲手機成像硬件方面的巨大進步,還是另有玄機?

相機:束縛重重的“黑箱”

爲了搞清楚這個問題,我們得回到相機工作的基本原理上來。關於相機成像質量好壞的判斷標準有很多,但在本文中,我們先聚焦在一個指標:分辨率。相機拍出來的照片畫質是否細膩,取決於在單位面積內有沒有足夠多的“色塊”來展現拍攝物體的複雜細節。分辨率越高,同時沒有各種“噪聲”來搗亂,你拍出來的照片就越清晰。

色塊(像素)密度越大,圖像分辨率越高

在大家的一般理解中,相機就是一個接收光線的“黑箱”:拍攝物體的光線通過相機鏡頭收集起來,成在底片上。然後我們只要把底片收集起來,讓它“顯影”就好了。這樣一個基於19世紀技術的關於相機“黑箱”的想象大體上仍然是正確的。它暗示了想要最終獲得一張照片所必需的兩個環節:一個是成像,一個是顯影。前者和光線和透鏡組本身的物理性質有關,對應着光學分辨率;後者則涉及光信息的收集和呈現方式,對應着圖像分辨率。二者共同決定了成像系統的解析力。

19世紀的攝像機(圖片來源:wikipedia)

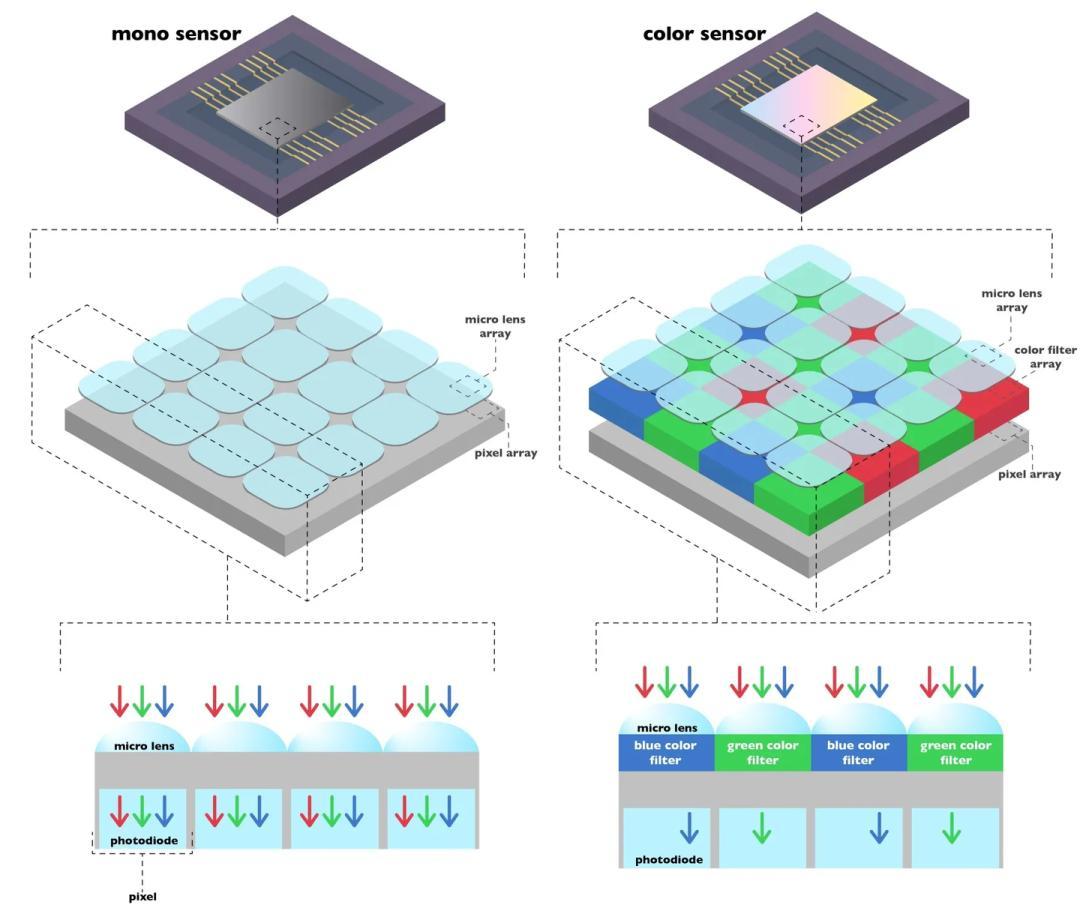

這個比喻唯一不足的地方在於,我們已經不再利用化學試劑,在一個昏暗的廂房裏“洗照片”。現代相機往往利用CMOS或者CCD收集光強信號。你可以把它想象成一個格子組成的陣列,光子打到每一個格子上後,光子被吸收,轉化爲電子的躍遷。這樣,光強信息就轉化爲了每一個格子上的電流信號。我們再通過模數轉換器將電信號化爲數字信號,成爲手機可以理解的“語言”,一張照片才最終呈現在我們的手機屏幕上。

單色(左)和彩色(右)相機傳感器陣列示意圖(圖片來源:OAK China)

很自然地想到,只要我們把傳感器的陣列做的夠密,每一個單位面積上都有很多個像素點來接收光的信息,那最後呈現的照片不就可以有超高的分辨率了嘛! 沒錯,提升傳感器的圖像分辨率的確是提升最終成像質量的最關鍵因素之一。手機廣告詞裏常說的“xx萬鏡頭像素”指的實際上就是傳感器的圖像分辨率,全畫幅、半畫幅”等專業相機的指標也是基於傳感器的面積和密度區分的。

但是手機鏡頭髮展到今天,圖像分辨率和畫質的提升已經越來越難,幾乎到達了瓶頸。這其中的原因是多方面的。首先最現實的因素是,目前的探測器尺寸已經接近物理極限,通過減小元尺寸和增加陣元數量的方式提高分辨率已經十分困難。特別對於某些特殊波段的探測器,如紅外探測器,受制作工藝、工作條件、功耗成本等因素的限制,陣列規模仍然較小、像元尺寸較大無法完整記錄光學圖像的全部信號,從而難以滿足對遠距離弱小目標精準探測/識別所需要的成像分辨率的需求。

好吧,那我們先退一步。假設半導體工藝足夠強,我們能把像素點做的更多更密,是不是成像質量就一定提高呢?也不行,因爲每一個“格點”做小了,光打到每一個接收器的信號就變弱了,相應地,噪聲就會凸顯出來,也就是我們常說的信噪比變低。這也就是爲什麼使用同樣的相機,你夜間拍攝的圖片似乎比白天要更“糊”。此外,高密度的探測器陣列會引入光電串擾問題,使得圖像質量進一步惡化。

我們再退一步,假設有一些神奇的設計和算法,能讓我們的探測器集成的越來越密,同時不發生信噪比降低和串擾,是不是我們的成像就能“無限”地好下去呢?此刻我們發現了一堵高牆,一個受物理法則支配、幾乎無法逾越的極限:光學衍射極限。

衍射極限:不可逾越的高牆?

上面的討論集中在探測器的圖像分辨率上,但是相機畢竟首先是一個光學成像系統,它受着物理定律的支配。在大部分時間裏,對於日常的攝影光學,你可以放心地將光視作一條條射線經過透鏡成像。空間中每一個幾何物點對應一個幾何像點,而幾何像點在概念上,是沒有面積的——它可以無限小。

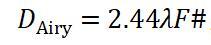

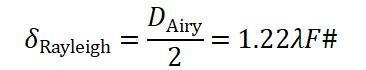

但不幸的是,隨着成像分辨率越來越高,以至於和光的波長量級接近的時候,光的波動性開始顯現。以至於即使是對於一個理想物點,經過一個沒有任何像差的完美透鏡成像,也得不到一個理想的幾何像點,而一定是一個光斑——這就是艾裏斑。艾裏斑的直徑可以由如下公式表達:

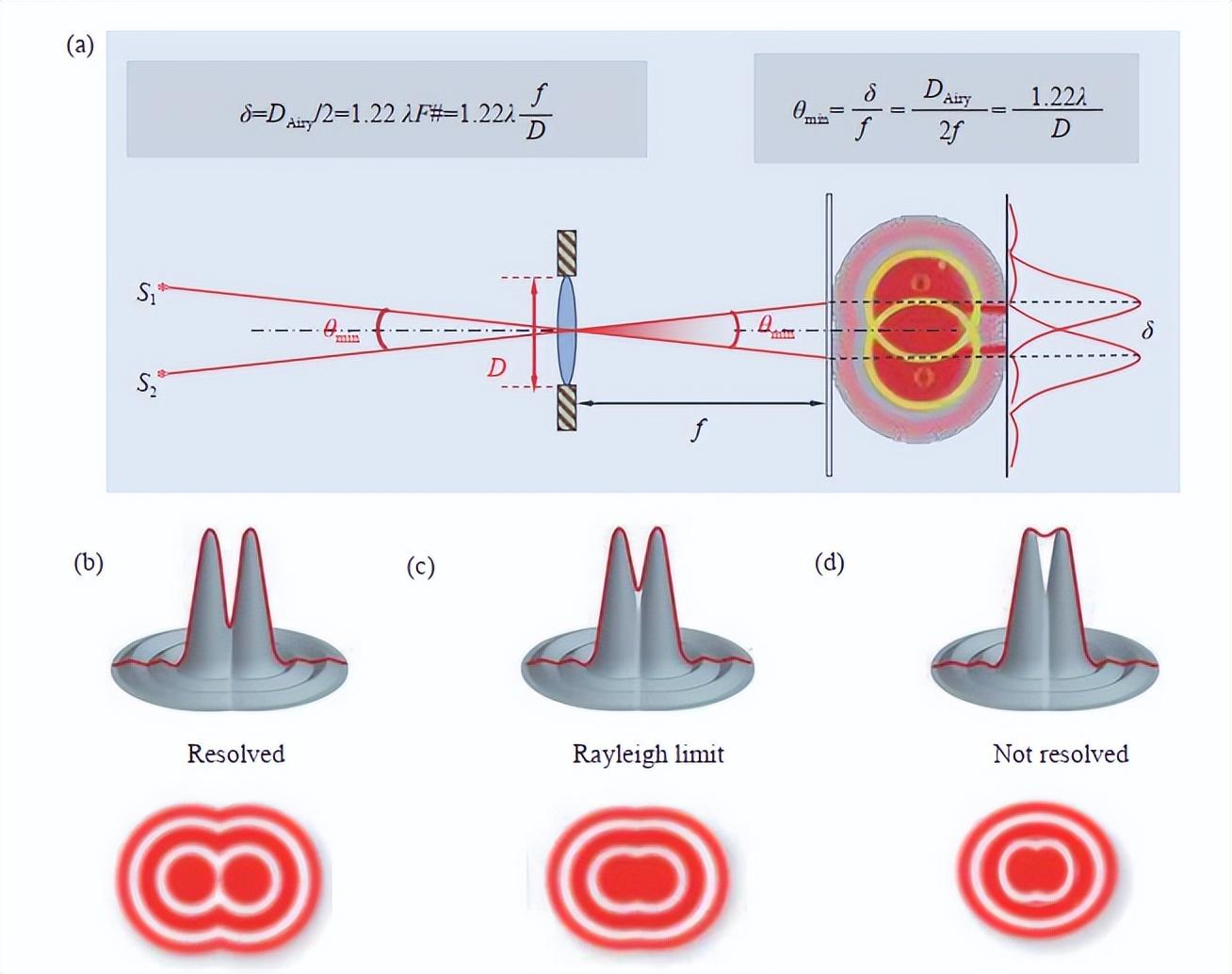

其中 是光的波長,“F#”表示鏡頭的光圈值。如果要把物空間的兩點區分出來,那就要求像空間的兩個光斑“不那麼重疊”,你能分辨出“這是兩個光斑”的最小距離,就是光學成像的衍射極限,它規定了光學分辨率的上限。

是光的波長,“F#”表示鏡頭的光圈值。如果要把物空間的兩點區分出來,那就要求像空間的兩個光斑“不那麼重疊”,你能分辨出“這是兩個光斑”的最小距離,就是光學成像的衍射極限,它規定了光學分辨率的上限。

物理學家瑞利勳爵(Lord Rayleigh)由此提出:當一個艾裏斑的邊緣與另一個艾裏斑的中心恰好重合時,此時對應的兩個物點剛好能被人眼或光學儀器所分辨,這就是著名的瑞利判據:

簡單的計算便可知,取綠光波長λ=520nm、鏡頭光圈值F#=1.4,δ=0.89μm;而取F#=5.6時,δ=3.56μm。

此時你會發現,將傳感器的像素越做越小的動力消失了——因爲傳感器像素的大小至少要大於瑞利判據,你才能分辨出空間兩點的成像,否則即使像素再密,你得到的也只是一團重疊的、“糊掉”的光斑。而目前的手機像素傳感器,實際上已經達到甚至超過了這個極限。以今年發佈的某款手機爲例,其ISOCELL傳感器已經達到了4800萬像素,每個像素的尺寸小到了0.8μm,與上面計算的瑞利判據非常接近。可以說,手機攝像的硬件傳感器已經基本走到了極限。

(a) 艾裏斑的形成 (b)-(d) 瑞利判據的可視化表達 (圖片來源:參考文獻[1])

計算成像:是輔助工具,還是突破極限的“神劍”?

結合以上知識,這裏可以回答文章最開始的問題了:受限於手機相機的像素尺寸、調焦的範圍,以及光學衍射極限的限制,我們幾乎不可能用傳統技術拍出紋理都顯示得一清二楚的月球照片。

那麼難道手機拍出的超高清月亮是“假”月亮?這就涉及到一個富有爭議的話題:有沒有可能打破光學衍射極限,使得小小的手機也能進行超分辨成像?

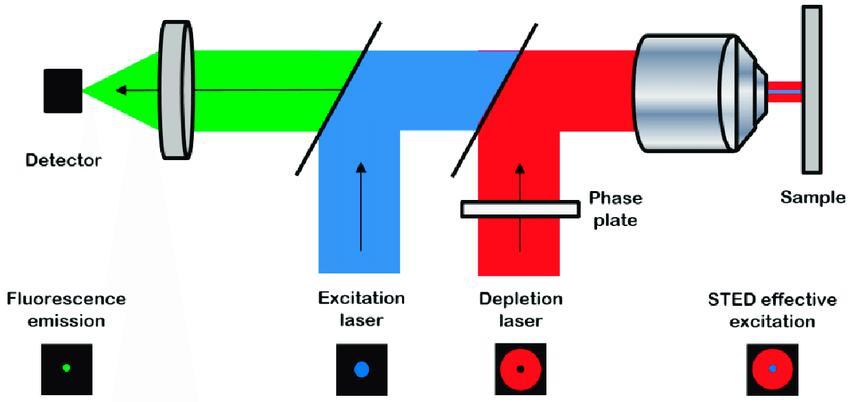

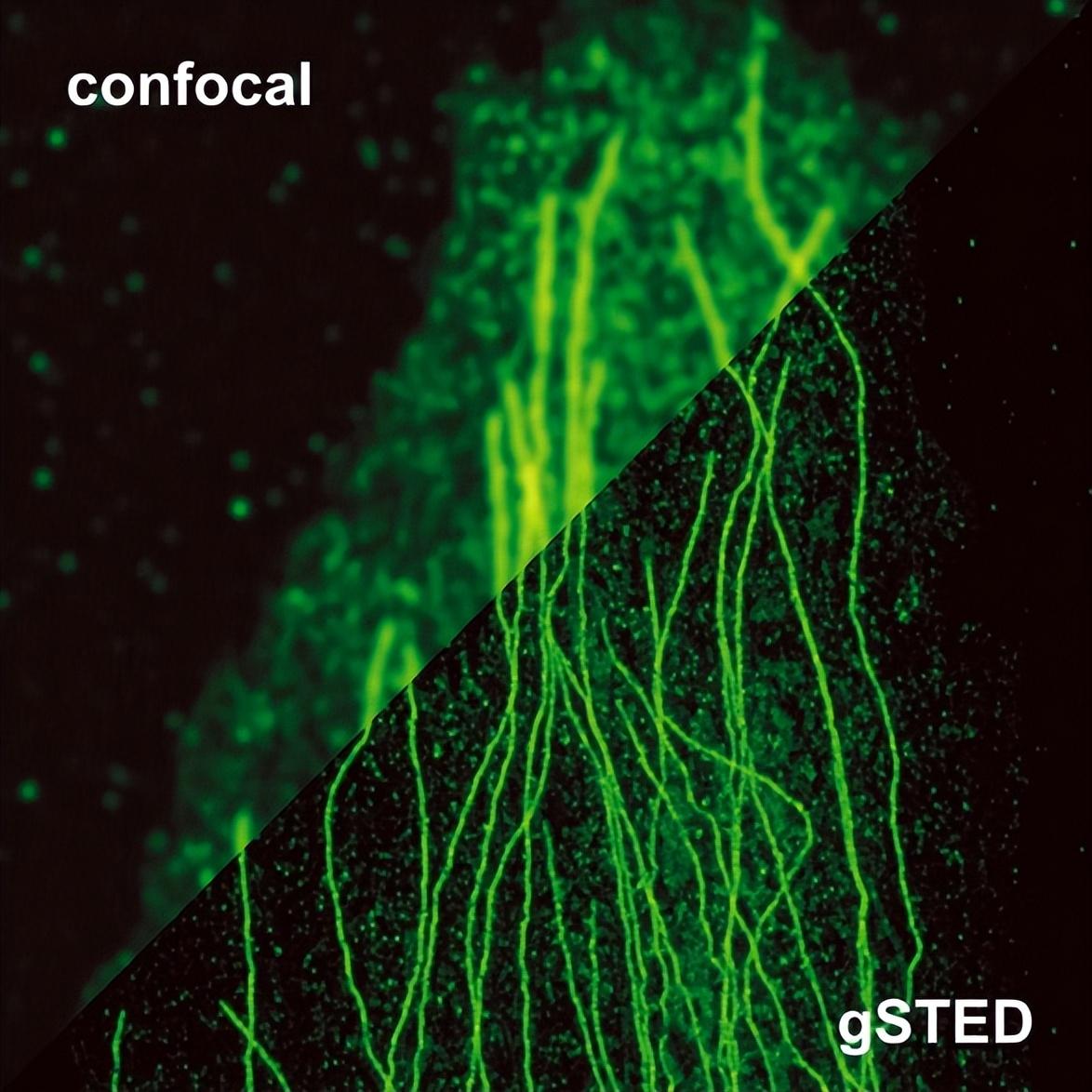

超分辨成像一直是科研界非常關心的一個方向。小到藥物分子的輸運,大到恆星之間的合併,科學家們常常需要在極端條件下獲得高清的圖像,理解現象背後的機制。美國及德國三位科學家Eric Betzig、Stefan W. Hell和William E. Moerner就因爲發明受激輻射損耗(Stimulated Emission Depletion,STED)顯微鏡以及單分子熒光定位技術獲得2014年諾貝爾化學獎。由於他們的貢獻,我們可以利用光學顯微鏡對納米世界一探究竟。這是通過設計新穎的光與物質相互作用的方法“繞過”光學衍射極限,因此是在底層物理上實現的“真正”的超分辨成像。

STED顯微鏡的基本結構和工作原理圖 (圖片來源:參考資料[3])

STED實現突破傳統光學極限的清晰成像 (圖片來源:PicoQuant)

然而,小小的手機上很難加裝如此龐大、複雜的科研設備。實際上,手機的超分辨成像走的是另外一條路——算法,尤其是基於深度學習和AI的算法。

我們從一個最直觀,也是最廣泛應用的例子談起。如果單張照片拍出來不夠清晰,或者是因爲手抖,或者是因爲特定的拍攝角度導致部分信息的缺失,或者是夜間光通量較少等各種原因,那麼多拍幾張不就得了!獲取多個圖像後,再把每一張中有用的信息都提取出一點,最後“合成”在一張照片上,那麼這張照片所包含的信息,不就遠遠超過單張照片所包含的信息量了?我們日常手機拍攝的照片中,很多都有這種“多幀合成”算法的影子。

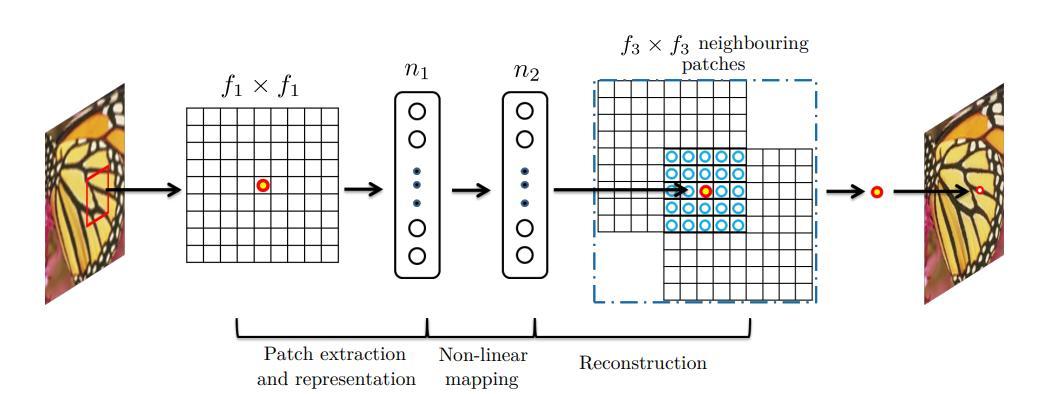

用深度卷積神經網絡(SRCNN)重建單幀圖像 (圖片來源:參考資料[4])

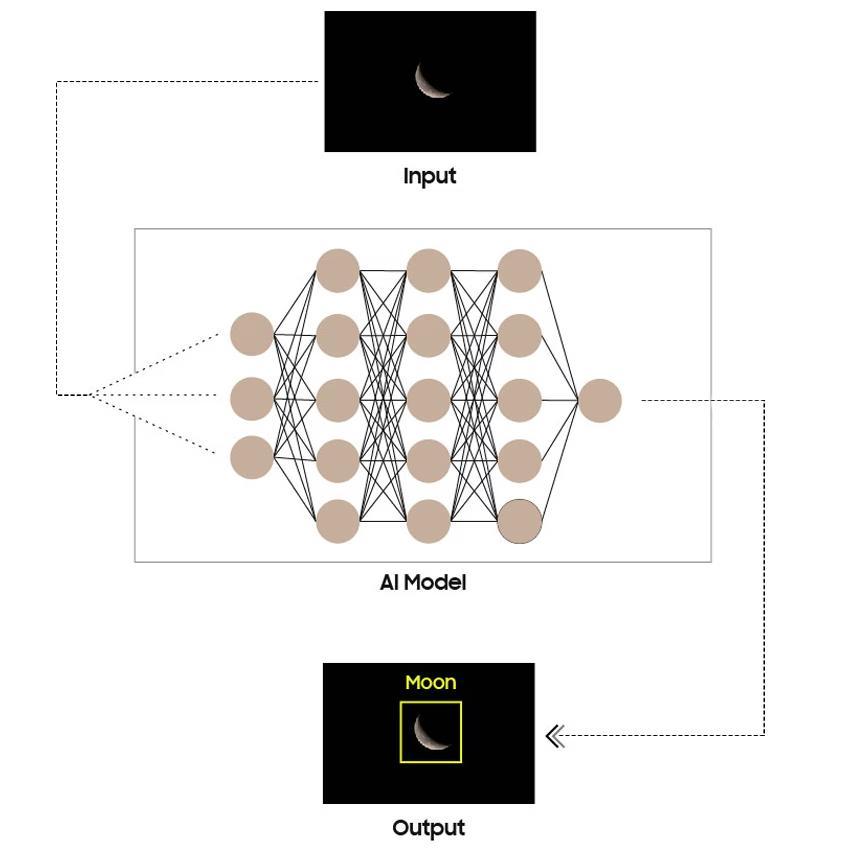

隨着算法不斷改進,現在甚至只需要一張照片就能進行超分辨重建。用通俗的語言來說,算法首先將待重建的圖像放大,再利用卷積神經網絡學習圖片的不同特徵,建立從低分辨率圖像到高分辨率圖像的關係。最後,在每一個局部都通過擬合將低分辨率的圖像映射到高分辨率的圖像,這樣就完成了超分辨圖像的“重建”。

深度學習處理拍攝的月亮圖像 (圖片來源:samsung)

然而,算法帶來了清晰的圖像,卻也模糊了“真”和“假”的界限。算法生成的圖像不是光學上真實捕捉到的圖像,而是一種“合理的想象”。如果我們要記錄一個確定已知的事物,同時有豐富的高清素材庫來預訓練神經網絡,那麼任何輸入進網絡的圖片,都能“自動”補齊它其實根本沒有捕捉到的細節。換言之,給一張低分辨率的圖片補充太多的先驗知識,它就會“有一個錘子,就看什麼都像錘子”。即使是一隻足球,經過算法處理後,也許也能呈現出月亮的模樣。

經過某款手機的深度學習算法處理後,模糊的月亮圖片增加了大量細節 (圖片來源:ibreakphotos)

當照相機第一次被髮明時,人們確信自己找到了忠實記錄光與影的方法;而在AI算法深度參與成像的今天,真實與虛構的界限再次變得模糊。李白的月亮有李白的情調,杜甫的月亮有杜甫的風雅,而現代人拍攝的月亮出奇的高清,卻也可能走向越發的一致。

參考文獻:

[1] 左超, and 陳錢. "分辨率, 超分辨率與空間帶寬積拓展—從計算光學成像角度的一些思考." 中國光學 (中英文) 15.6 (2022): 1105-1166.

[2] 熊婭維, 王安志, and 張凱麗. "基於深度學習的光場超分辨率算法綜述." Laser & Optoelectronics Progress 61.18 (2024): 1800003-1800003.

[3] Paës G, Habrant A, Terryn C. Fluorescent nano-probes to image plant cell walls by super-resolution STED microscopy[J]. Plants, 2018, 7(1): 11.

[4] Shi, Wenzhe, et al. "Real-time single image and video super-resolution using an efficient sub-pixel convolutional neural network." Proceedings of the IEEE conference on computer vision and pattern recognition. 2016.

作者:陳明遠

作者單位:南京大學