大晚上被 AI 整哭了,代碼預設的共情怎麼不算共情?!

當你心情不好的時候,你會找誰傾訴?

最近幾年,deepseek、GPT、豆包等聊天 AI 興起之後,找 AI 傾訴成爲了不少人的選擇。而且很多人會發現,在和聊天 AI 對話之後,真的會覺得自己被安慰到了。

被AI安慰到的人們,圖片截取自網絡

其實不光是國內,國外的 reddit 上,也有不少類似的情況,網友們覺得自己被 AI 安慰到了。

我本不指望 AI 能安慰我,但發生了這件事,圖片來源:reddit

如果仔細一想,這件事的背後似乎存在一個巨大的矛盾。

一方面,科學家不停地告訴我們“AI 是沒有情感的”“它們的回覆只是代碼運行的結果”。但另一方面,AI 似乎比大部分人類更知道怎樣去安慰人。如果 AI 真的毫無情感,它們怎麼可能做到這一點?

其實這一切並不矛盾,你之所以被安慰到,是“沒有情感的 AI”和“有情感的你”共同造就的。

ELIZA 效應,來自 60 年前的安慰

現代的聊天 AI 大部分是建立在大語言模型的基礎上的,而大語言模型,又是以神經網絡爲基礎的。

有些人可能聽說過一種說法,神經網絡處理數據的過程像是一個黑箱,這給人們留下了“聯想”的空間,認爲在這個“黑箱”運行的過程中,AI 產生了情感。

爲了撇開這一因素的影響,我們不妨從更簡單的情況說起。

大約在 60 年前,出現過一款聊天機器人——ELIZA。它是麻省理工學院的科學家約瑟夫·維森鮑姆(Joseph Weizenbaum)開發的。

維森鮑姆曾經還爲 ELIZA 開發過一個模擬心理醫生的腳本(DOCTOR 腳本),讓它模擬心理醫生與人類對話。

雖然模擬的是心理醫生,但鑑於當時的技術限制,ELIZA 只能檢測語句中的關鍵詞,然後按照人類科學家設定的規則進行回覆。

舉個例子,當你對 ELIZA 說“我對我的朋友感到很失望”的時候,ELIZA 會進行簡單的重複並且對“我”這樣的人稱代詞進行替換,回覆你“你說你對你的朋友感到很失望?”

然後按照規則,當有“失望”這樣的詞出現的時候,它會在後面增加一小句“能多說一說嗎?”或者“你爲什麼會感到失望?”

這樣的技術在今天看來是相當簡單的,但也正是這種簡單的技術,使得它的整個對話過程不存在任何“黑箱”,也就沒有給人們留下任何可供聯想的空間。毫無疑問 ELIZA 是沒有智能的,也說不上“理解”人類的情感。

但就連 ELIZA 的設計者維森鮑姆自己也沒有想到,在與 ELIZA 的對話過程中,有些學生認爲 ELIZA 是有情感有思想的,甚至還想要和 ELIZA 獨處。

這種現象後來被人們稱作“ELIZA 效應”,即人們會把人類的特質(比如同理心、情感、思想等等)投射到簡單的計算機程序上。

從這個例子中我們可以看到,ELIZA 這種簡單的聊天 AI 肯定是不具備人類情感的,但人們依然能從它的回覆中“解讀”出情感,並且會被它安慰到。

大語言模型,遠超 ELIZA 的存在

再回到現在的聊天 AI 上,經過約 60 年的發展,人工智能技術已今非昔比。

大語言模型讓聊天機器人能夠從海量的人類文本中尋找詞彙背後的語義關係。它們還能夠針對你說的話,給出最合適的回覆。

這些回覆已經不僅僅是語句通順這麼簡單了,如果不給提示,你甚至都很難判斷出和自己對話的到底是人類還是 AI。

比如,在 2025 年 3 月的一篇文章中就對 GPT-4.5、LLaMa-3.1、ELIZA 和 GPT-4o 等 AI 模型進行了圖靈測試,結果發現,對於 GPT-4.5 這樣的模型,能讓超過 73% 的人認爲它是人類。

相比之下,只有 23% 的人把 ELIZA 這樣的聊天 AI 判斷爲人類。

你可以想象,就連簡單的 ELIZA 都能引起“ELIZA 效應”,讓人類誤認爲它能夠理解我們的情感。在與能力更強大的現代 AI 進行對話的時候,產生“它理解我”這樣的感受就更不讓人意外了。

算法也真的讓 AI 比人類更“懂你”

其實在 20 世紀末,就已經有科學家開始着手研究情感計算方面的課題了。

這一領域的核心任務就是通過文本、語音、面部表情、心電圖、腦電圖等維度的參數準確識別人類的情緒,從而提供更有針對性的AI交互。

在最近幾年,隨着訓練數據量和參數規模越來越大,大語言模型也湧現出了“理解”人類情感的能力。但這個“理解”和人類意義上的理解並不相同。它們對情感的理解主要是通過語義關聯以及上下文關聯實現的。

比如當出現了“悲傷”這樣的詞,AI 能夠通過訓練數據學習到人類通常會如何回應這個詞,說什麼樣的話才合適。

另外,針對一段描述,AI 也能很快地意識到它與什麼樣的情緒有關,而且在識別人類情緒上,它們甚至比人類更懂人類。

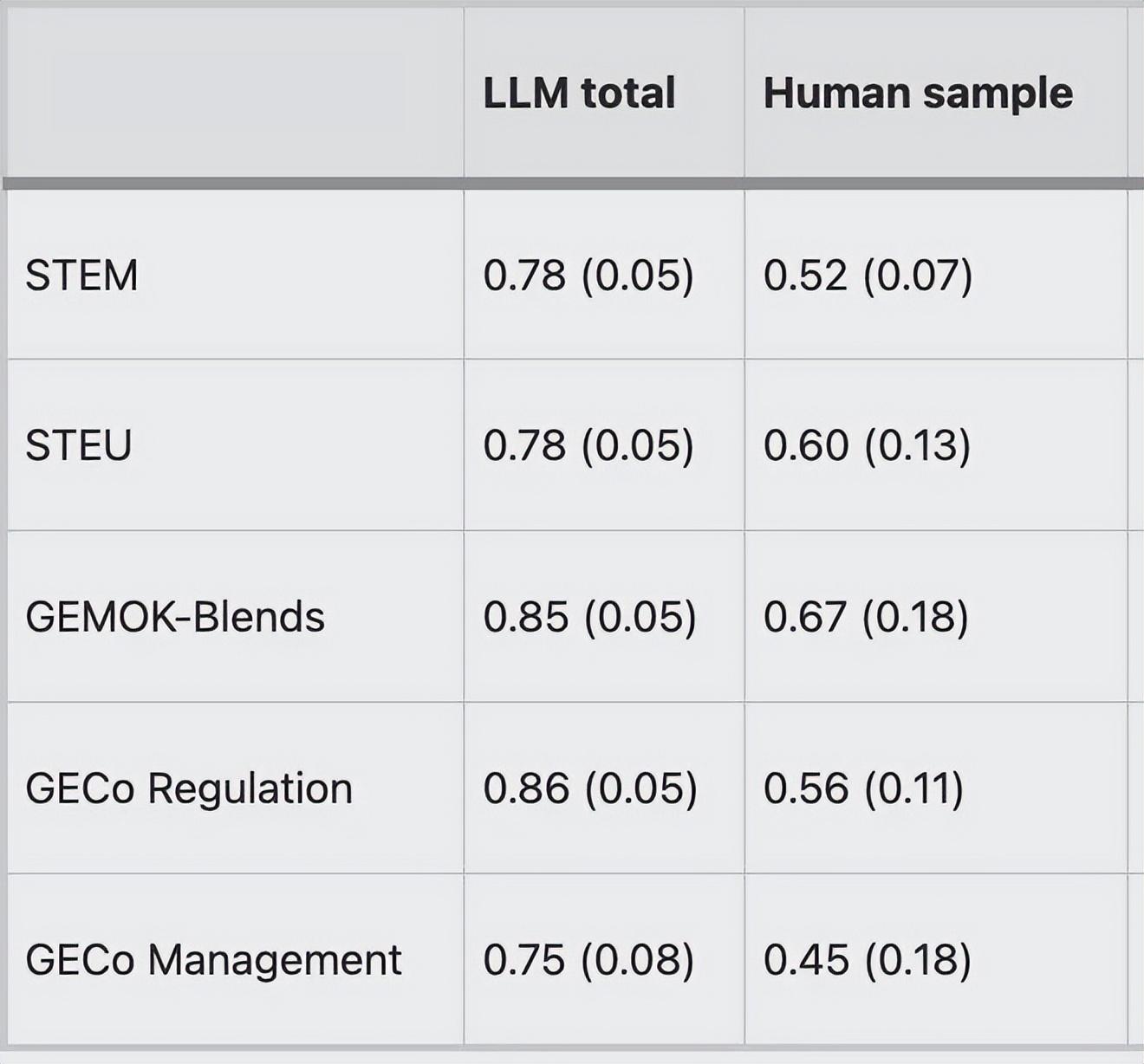

2025 年發表在《傳播心理學》上的一項研究就證明了這一點。

這項研究對比了Chat GPT-4、Chat GPT-o1、Gemini 1.5 flash、DeepSeek V3 等大語言模型與人類在 5 項情緒識別測試上的表現,結果發現在 5 項測試中,AI 的表現均比人類要好。

大語言模型和人類在5項測試中的表現(得分越高越好),圖片來源:參考文獻[2]

可以說,AI 能從文本數據中識別出你的情緒,並且給出相當像模像樣的回覆。這樣的能力甚至超過了很多人類的水平。

但遺憾的是,說出這些暖心的回覆並不是因爲它們共情了,它們沒有情感,它們的回覆確實只是遵循代碼和模型設定而已。

冰冷的算法與真實的安慰

雖然算法的內核是冰冷的,但 AI 能讓人類感受到情感上的慰藉卻是真實的,二者並不矛盾。

在“移動互聯”和社交媒體興盛的時代,人與人之間的關聯似乎並沒有隨着這種“互聯”而加強。在社會疏離感和孤立感日益加深的時代裏,“被關注到”這樣的需求很難被滿足。

而當我們與聊天 AI 對話的過程中,AI 不僅能夠記住你說的每一句話,還能隨時隨地提供反饋,爲人們創造了一種“被關注”的感受。此外,很多你不敢和周圍朋友或者熟人傾訴的煩惱,你可以毫無顧慮地對 AI 說,這是人類朋友很難做到的。

還有,在與 AI 的交流的過程中你肯定也能發現,AI 擁有無限的耐心,哪怕你一遍又一遍地傾訴煩惱,甚至用了極其不尊重的語氣,AI 依然能夠給你正向的回應(如果換成人類,可能對方已經翻臉了)。

雖然人類的心理諮詢師也可以提供類似的幫助,但這對大部分人來說成本太高了,而手機上隨時可以對話的 AI,能夠最低成本滿足我們“被傾聽”的需求。

雖然普通人“被看見”“被傾聽”這樣的需求從社會“大視野”中來看微不足道,但是這對具體的人來說非常重要。

聊天 AI 確實能滿足這樣的需求,如果你在和 AI 交流的過程中覺得被“冰冷的算法”安慰到了,這很正常。

但唯一需要注意的是,在和 AI 交流的過程中,不要沉溺其中。和 AI 交流傾訴,是爲了讓我們擺脫煩惱,更好地回到生活中去。在真實的生活中去尋找那些真正關心你的人,這纔是最重要的。

參考文獻

[1] Jones, C. R., & Bergen, B. K. (2025). Large language models pass the turing test. arXiv preprint arXiv:2503.23674.

[2] Schlegel, K., Sommer, N. R., & Mortillaro, M. (2025). Large language models are proficient in solving and creating emotional intelligence tests. Communications Psychology, 3(1), 80.

[3] Andersson, M. (2025). Companionship in code: AI’s role in the future of human connection. Humanities and Social Sciences Communications, 12(1), 1-7.

策劃製作

本文爲科普中國·創作培育計劃扶持作品

出品丨中國科協科普部

監製丨中國科學技術出版社有限公司、北京中科星河文化傳媒有限公司

作者丨科學邊角料 科普作者

審覈丨於乃功 北京工業大學教授 中國人工智能學會理事

策劃丨符思佳

責編丨符思佳

審校丨徐來 張林林